еҚҺдёәдә‘ж‘ҳеҫ—дҝЎжҒҜжЈҖзҙўйўҶеҹҹеӣҪйҷ…жқғеЁҒжҜ”иөӣйҮ‘зүҢпјҢе®һеҠӣе…Ёи§Јжһҗ( дёү )

----еҚҺдёәдә‘ж‘ҳеҫ—дҝЎжҒҜжЈҖзҙўйўҶеҹҹеӣҪйҷ…жқғеЁҒжҜ”иөӣйҮ‘зүҢ пјҢ е®һеҠӣе…Ёи§Јжһҗ//----

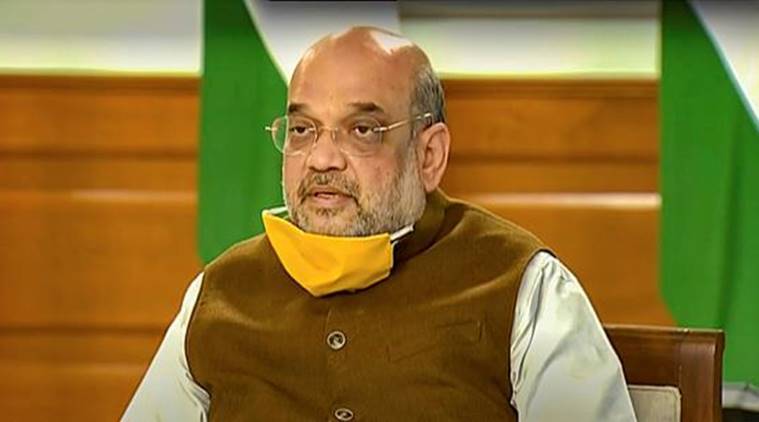

гҖҖгҖҖеӣҫ4 BioBERTз»“жһ„еӣҫ (еӣҫеј•иҮӘ[6])

гҖҖгҖҖ4.4 жЁЎеһӢиһҚеҗҲ

гҖҖгҖҖеңЁжЁЎеһӢиһҚеҗҲзҡ„иҝҮзЁӢдёӯ,жҲ‘们иҝҗз”ЁдәҶ6з§Қе…ұ9дёӘз»ҸиҝҮ科еӯҰе’Ңз”ҹзү©еҢ»иҚҜиҜӯж–ҷеә“и®ӯз»ғзҡ„йў„и®ӯз»ғжЁЎеһӢеҲҶеҲ«дёә:BioBERT_v1.1* 3, BioBERT_v1.0_PubMed_PMC * 2, BioBERT_v1.0_PubMed* 1,BioBERT_v1.0_PMC * 1, BioBERT_dish*1,SciBERT* 1 гҖӮ 他们зҡ„еҚ•жЁЎеһӢеңЁиҜҘд»»еҠЎдёӯзҡ„жҖ§иғҪеҰӮиЎЁ2жүҖзӨә гҖӮ

----еҚҺдёәдә‘ж‘ҳеҫ—дҝЎжҒҜжЈҖзҙўйўҶеҹҹеӣҪйҷ…жқғеЁҒжҜ”иөӣйҮ‘зүҢ пјҢ е®һеҠӣе…Ёи§Јжһҗ//----

гҖҖгҖҖиЎЁ2 еҚ•жЁЎеһӢжҖ§иғҪ

гҖҖгҖҖ然еҗҺжҲ‘们еҜ№еҚ•жЁЎеһӢиҫ“еҮәзҡ„жҰӮзҺҮз»“жһңиҝӣиЎҢblendingж“ҚдҪңеҰӮеӣҫ5жүҖзӨә,еҫ—еҲ°жңҖеҗҺзҡ„жЁЎеһӢз»“жһң,е…¶жҜ”жңҖеҘҪзҡ„еҚ•жЁЎеһӢз»“жһңжҸҗеҚҮдәҶ1дёӘзҷҫеҲҶзӮ№е·ҰеҸі гҖӮ

----еҚҺдёәдә‘ж‘ҳеҫ—дҝЎжҒҜжЈҖзҙўйўҶеҹҹеӣҪйҷ…жқғеЁҒжҜ”иөӣйҮ‘зүҢ пјҢ е®һеҠӣе…Ёи§Јжһҗ//----

гҖҖгҖҖеӣҫ5 жЁЎеһӢиһҚеҗҲ

гҖҖгҖҖ5гҖҒжҖ»з»“дёҺеұ•жңӣ

гҖҖгҖҖжң¬ж–Үдё»иҰҒеҜ№жҜ”иөӣдёӯжүҖдҪҝз”Ёзҡ„е…ій”®жҠҖжңҜиҝӣиЎҢдәҶд»Ӣз»Қ,еҰӮж•°жҚ®еӨ„зҗҶ,еҖҷйҖүи®әж–Үзҡ„еҸ¬еӣһдёҺйҮҚжҺ’,жЁЎеһӢиһҚеҗҲзӯү гҖӮ еңЁжҜ”иөӣдёӯдҪҝз”Ёдё“жңүйўҶеҹҹи®ӯз»ғеҗҺзҡ„йў„и®ӯз»ғжЁЎеһӢиҫғйҖҡз”ЁйўҶеҹҹйў„и®ӯз»ғжЁЎеһӢж•ҲжһңжңүиҫғеӨ§зҡ„жҸҗеҚҮ гҖӮ з”ұдәҺжҜ”иөӣж—¶й—ҙзҡ„йҷҗеҲ¶,и®ёеӨҡж–№жі•иҝҳжІЎжқҘеҫ—еҸҠиҜ•йӘҢ,жҜ”еҰӮеңЁжҜ”иөӣдёӯз”ұдәҺжӯЈиҙҹж ·жң¬дёҚе№іиЎЎ,еҜјиҮҙжЁЎеһӢи®ӯз»ғз»“жһңдёҚзҗҶжғі,еҸҜд»ҘеҗҲзҗҶзҡ„дҪҝз”ЁдёҠйҮҮж ·жҲ–дёӢйҮҮж ·жқҘдҪҝж ·жң¬иҫҫеҲ°зӣёеҜ№е№іиЎЎ,жҸҗеҚҮжЁЎеһӢи®ӯз»ғж•Ҳжһң гҖӮ

гҖҖгҖҖеҸӮиҖғж–ҮзҢ®

гҖҖгҖҖ[1] Yang W, Zhang H, Lin J. Simple applications of BERT for ad hoc document

гҖҖгҖҖretrieval[J]. arXiv preprint arXiv:1903.10972, 2019.

гҖҖгҖҖ[2] Gupta V, Chinnakotla M, Shrivastava M. Retrieve and re-rank: A simple and

гҖҖгҖҖeffective IR approach to simple question answering over knowledge

гҖҖгҖҖgraphs[C]//Proceedings of the First Workshop on Fact Extraction and

гҖҖгҖҖVERification (FEVER). 2018: 22-27.

гҖҖгҖҖ[3] Peters M E, Neumann M, Iyyer M, et al. Deep contextualized word

гҖҖгҖҖrepresentations[J]. arXiv preprint arXiv:1802.05365, 2018.

гҖҖгҖҖ[4] Radford A, Wu J, Child R, et al. Language models are unsupervised multitask

жҺЁиҚҗйҳ…иҜ»

- еҚҺдёәдә‘еҗҜеҠЁе…ЁзҗғжҠ—з–«иЎҢеҠЁпјҢеҸӮдёҺи®ЎеҲ’дјҷдјҙе°ҶиҺ·жңҖй«ҳ30000зҫҺе…ғе…Қиҙ№дә‘иө„жәҗ

- гҖҺ科жҠҖжӢҢйҘӯгҖҸж•Ңдәәж— еӨ„йҒҒеҪўпјҢжүӢжңәеҸҳиә«зү©зҗҶеӨ–жҢӮпјҹеҚҺдёәMateXsеҸҢеҖҚи§ҶйҮҺеҲҡжһӘ

- [欧йҳіе…¬жҳҺд»”зҲ¶]еҚҺдёәP40е·Іж‘Ҷи„ұи°·жӯҢйҳҙеҪұпјҹиҝҲеҗ‘иҮӘдё»зі»з»ҹд»ҚжңүжҢ‘жҲҳ

- еҚҺдёәв– еҚҺдёәP40 ProеҶ°йңң银вҖңзҘһд»ҷеӣҫиөҸвҖқпјҡйўңеҖје·…еі°пјӢDxOйңёжҰңпјӢж——иҲ°жҖ§иғҪ

- #еҚҺдёә#еҚҺдёә P40 Pro еҶ°йңң银иөҸжһҗпјҡеӣӣжӣІж»ЎжәўеұҸ + е“‘е…үжңәиә«

- еҚҺдёәдёҺз»ҹдҝЎиҪҜ件зӯҫзҪІеҗҲдҪңеҚҸи®®пјҢжҗәжүӢе…ұе»әйІІй№ҸжЎҢйқўдә‘ж–°з”ҹжҖҒ

- гҖҺе…ЁеӣҪиғҪжәҗдҝЎжҒҜе№іеҸ°гҖҸ并йҮҚз”і2025е№ҙеүҚе№ҙдә§80дёҮиҫҶз”өеҠЁжұҪиҪҰзӣ®ж ҮпјҢеҘҘиҝӘиҜҰи§Ј4еӨ§з”өеҠЁиҪҰе№іеҸ°

- з»ҸжөҺж—ҘжҠҘпјҡеҚҺдёәе®ҢжҲҗдёӯеӣҪдјҳжғ иҙ·ж¬ҫеҗҲдҪңйЎ№зӣ®вҖ”вҖ”вҖңжҷәж…§еЎһеҶ…еҠ е°”вҖқеҠ©еҠӣеЎһж”ҝеәңдёҫиЎҢйҰ–ж¬ЎиҝңзЁӢеҶ…йҳҒдјҡи®®

- гҖҢP40гҖҚжңӘеҸ‘еёғжүӢжңәзӣҳзӮ№пјҢеҚҺдёәжң¬жңҲеёҰжқҘ8ж¬ҫж–°жңәпјҢиҝҳжңүдёҖж¬ҫйә’йәҹ810е…Ҙй—ЁжңәеһӢ

- йә’йәҹ820пјҡйә’йәҹ820е®ҢиҷҗйӘҒйҫҷ756GпјҢеҚҺдёәиҠҜзүҮз»ҲдәҺеҮәдәҶдёҖеҸЈж°”