「人工智能」利用移动AR数据,谷歌训练了一款可在2D图像中识别3D的AI框架

3月12消息 , 谷歌AI团队公布了一种全新的移动端3D识别方案:Objectron , 其特点是可通过AI模型 , 在2D图像中预测物体在场景中的位置、尺寸和方向 , 可用于机器人、自动驾驶汽车、图像检索、AR等场景 。

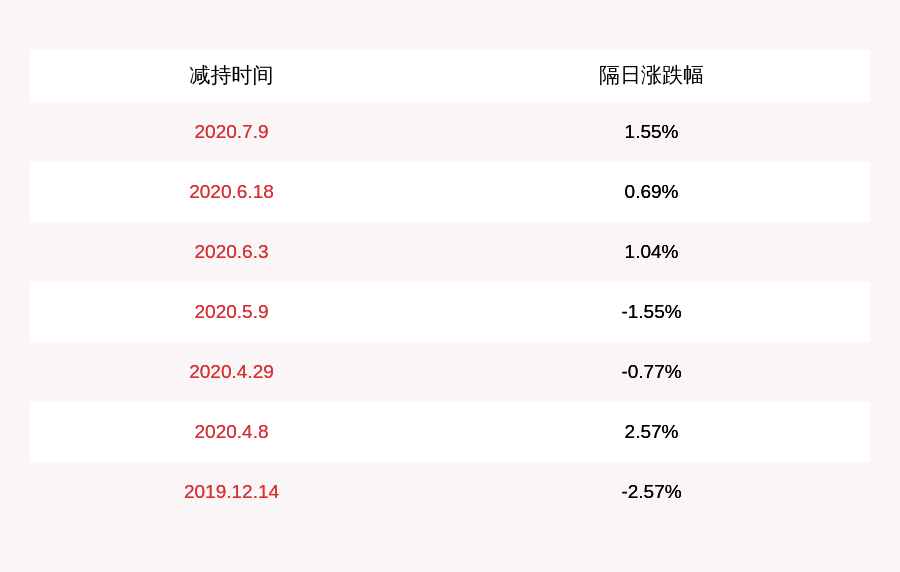

本文插图

此外 , Objectron的研发团队开发了一种图片标记工具 , 可以通过分屏视角显示2D视频帧 , 快速实现对3D边界框的手动标记 。 这些3D边界框将叠加在点云数据、摄像头画面和识别到的平面上面 。

标采访人员在分屏视角(3D视角)中标记3D边界框后 , 可以在2D视频帧中进行验证 , 而对于静态图像 , 标采访人员只需在单个帧中进行标记 。 为了更精准定位目标物体 , 标记工具还会使用AR session数据中的实际摄像头信息来确定该物体在所有帧中的位置 。

接下来为了训练AI模型 , 谷歌团队使用了移动端AR session数据(包括摄像头图像、稀疏3D点云、预测光线、平面区域等) , 弥补了移动设备不具备高端3D传感器的难题(市面上大多数3D数据依赖激光雷达等3D传感器 , 对日常物体的3D标记数据却很少) 。

除了真实环境的数据外 , 还使用了合成的AR数据来提高AI预测准确性 。 为提高合成数据的质量(提升了10%准确性) , 谷歌研发了一个AR合成数据生成方案(AR Synthetic Data Generation) , 特点是可通过调整摄像头角度、识别平面、预测的光线数据 , 来生成符合物理规则的3D位置信息 , 以及符合场景的光线 , 让融入在具有AR session数据的场景中的虚拟物体看起来更自然 。

同时 , 谷歌表示:由于SoC等硬件设备局限 , 用手机等移动设备识别3D目标是一个棘手的问题 , 而在2D视频、图片中识别物体的3D信息更是难上加难(由于缺乏深度数据 , 以及画面复杂性等因素) , 通常只能识别和标记2D信息 。

【「人工智能」利用移动AR数据,谷歌训练了一款可在2D图像中识别3D的AI框架】因此利用开源跨平台框架MediaPipe , Objectron可实现在旗舰级移动设备中实时标记3D边界框的任务 , 比如在搭载Adreno 650移动图形芯片的LG V60 ThinQ、三星Galaxy S20+、索尼Xperia 1 II等手机上 , 刷新率约可达26fps 。

推荐阅读

- 2020改变就在眼前,量化派助力多行业人工智能化

- 『接风娱乐』人机对战协作新时期已经来临,提高智能化与人工智能技术趋于结合

- 『C114通信网』中国首个200G商用骨干网:从集采看中国移动光网络创新持续发力

- 极速聊科技:诺基亚、爱立信措手不及!,中国移动超硬核!国产5G全面崛起

- 宜宾新闻网▲高县成功举办秸秆综合利用现场会

- 游戏谈▲人工智能上线助力疫情!5天时间如何如何完成?

- 云都科技发布MESH自组网移动专用设备

- 真的会有报复性消费吗?猎豹移动机器人大数据告诉你

- [人工智能]“智慧大脑”赋能河南制造

- 『镁客网TB』目标游戏玩家和内容创作者,英特尔推出第十代酷睿移动处理器