技术终于有人对语音技术来了次彻头彻尾的批判( 五 )

传统意义上 , 在机器学习中 , 新的想法已经以数学公式的形式共享了 。 这种做法历史悠久 , 也容易理解 , 但存在缺陷 。 由于如今开源工具的广泛采用 , 在构建应用解决方案、优化现有方案、解释事物运行方式(这是一项单独的艰苦工作)、构建基本模块或框架(如果百度构建的warp-ctc , 或者脸书构建的PyTorch)和创建新的数学方法存在着明显的分界线 。

机器学习的研究人员通常都同意这个看法:论文中存在很多为方程式而方程式的内容 。 但它们是否真的有助于我们理解事物的真正运行方式呢?我们以CTC(Connectionist Temporal Classification)损失为例来说明这个观点 。 几乎每篇用到这个损失的STT论文中都有专门的章节来描述 , 你可能会在其中找到一些公式 , 但是否能帮助你理解呢?

CTC损失是个复杂的问题 , 而且很可能是STT研究最大的推动力 , 但很少有论文提到它们使用了哪种实现 。 在我读过的论文中 , 还没看到下列看法 。 该怪我的无知 , 或者实现时的怪癖 , 还是他们故意忽略了这些内容呢?

- 每3个月 , 我会将warp-ctc与PyTorch原生的CTC损失相比较 , 使用真实数据时后者无法正常运作;

- 与标准损失相比 , CTC损失相当“激进”;

- 通常需要某种形式的修剪或预热 , CTC损失“喜欢”爆炸;

- 对于在第一阶段向你的网络展示哪些数据 , 你应当非常小心 。

试想一下 , 如果机器学习论文和出版物遵循以下模板 , 传递结果的难度要降低多少:

- 使用这些工具包、实现和想法;

- 进行这些主要的改动;

- 运行这些试验 , 这是我们的结论 。

我们来看看从推广ASR的原始论文Deep Speech 2开始 , 到现在进步了多少 。

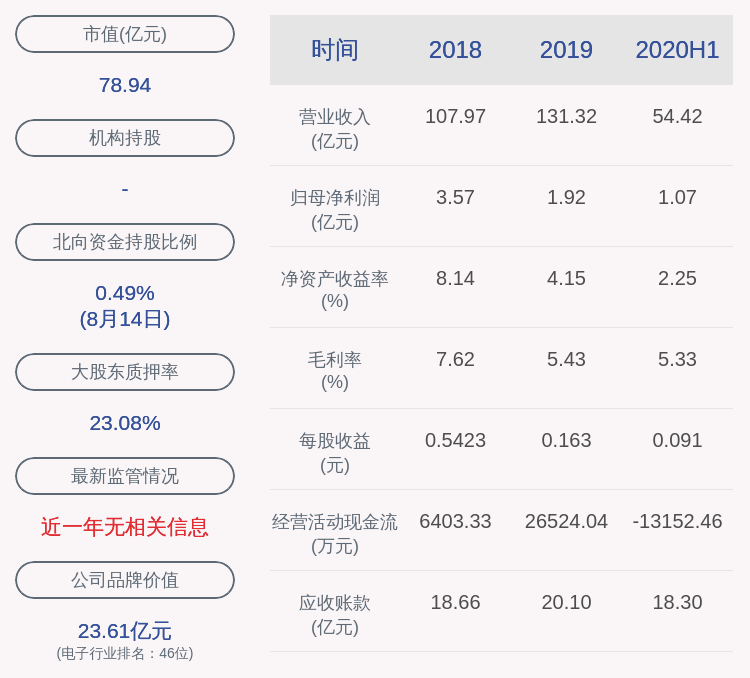

本文插图

从这篇论文改编 , 《Deep Speech 2》的论文中所报告的人类结果 。

是否似乎字符错误率(CER)和词组错误率(WER)的指标实际上降低了60% , 并超过了人类水平?因此 , 如果运行效果如此之好 , 为什么我们不能在每台设备上看到理想的STT弹出?为什么语音接口仍被认为是一项很酷的功能 , 特别是在商业应用中?

尽管根据下表的数据 , 在转到音频时 , 人类通常会有5-10%的错误率 , 但这个表格具有误导性 。 我们阅读了一些论文 , 并发现了一些情况:

- 较新的论文很少使用较小的模型来执行消融试验(ablation tests);

- 声称包含最先进性能的ASR论文很少会出现收敛曲线;

- 这些论文很少报告用于超参数搜索和模型收敛的计算量;

- 在我们读过的论文中 , 仅有Deep Speech 2对较小型数据集上的性能如何转化到实际生活的数据方面有所关注(即域外验证);

- 没有针对真实数据集的样本效率和可伸缩性做过优化 。 2019年的几篇论文与(Time-Depth Separable Convolutions, QuartzNet)讲述的内容大致相似 , 但更关注减少模型大小 , 而不是训练时间 。

推荐阅读

- |荷兰企业推出全新半导体技术,并承诺对华投资!中国光刻机获突破

- 辰宜科技|区块链技术与应用专题分享交流会

- 吴铭园|华为概念机设计图首次曝光,居然采用屏下摄像头技术

- |小米快跟进!华为新专利曝光:屏下摄像头终于要来了

- 数码与拖拉机维修技术|经典性价比机型再升级:TS-453Dmini 2.5GbE NAS拆解体验

- |《5G技术助力国产机器人完成全球首场骨科实时远程手术》公示材料

- 电热汇|科普:冷却塔的选择、配置与安装详解

- 兰州新闻网|创新驱动 情报先行——记兰州市科学技术情报研究所

- 最极客网|原创 中兴推5G视频手机,衰颓之后还能凭技术回归主流吗?

- CSDN|牛!2020年,这项技术将获得99000000000元人民币“国家领投”!