гҖҗAndroidи§Ҷйў‘жҠҖжңҜжҺўзҙўд№Ӣж—…пјҡзҫҺеӣўеӨ–еҚ–е•Ҷ家з«Ҝзҡ„е®һи·өгҖ‘public static double correctTimeToSyncSample(Track track, double cutHere, boolean next) { double[] timeOfSyncSamples = new double[track.getSyncSamples().length]; long currentSample = 0; double currentTime = 0; for (int i = 0; i < track.getSampleDurations().length; i++) { long delta = track.getSampleDurations()[i]; int index = Arrays.binarySearch(track.getSyncSamples(), currentSample + 1); if (index >= 0) { timeOfSyncSamples[index] = currentTime; } currentTime += ((double) delta / (double) track.getTrackMetaData().getTimescale()); currentSample++; } double previous = 0; for (double timeOfSyncSample : timeOfSyncSamples) { if (timeOfSyncSample > cutHere) { if (next) { return timeOfSyncSample; } else { return previous; } } previous = timeOfSyncSample; } return timeOfSyncSamples[timeOfSyncSamples.length - 1];}дёәдәҶи§ЈеҶізІҫеәҰй—®йўҳ пјҢ жҲ‘们еәҹејғдәҶmp4parser пјҢ йҮҮз”ЁMediaCodecзҡ„ж–№жЎҲ пјҢ иҷҪ然иҜҘж–№жЎҲдјҡеўһеҠ еӨҚжқӮеәҰ пјҢ дҪҶжҳҜиҜҜе·®зІҫеәҰеӨ§еӨ§йҷҚдҪҺ гҖӮ

ж–№жЎҲе…·дҪ“е®һж–ҪеҰӮдёӢпјҡе…ҲиҺ·еҫ—зӣ®ж Үж—¶й—ҙзҡ„дёҠдёҖеё§дҝЎжҒҜ пјҢ еҜ№и§Ҷйў‘и§Јз Ғ пјҢ 然еҗҺж №жҚ®иө·е§Ӣж—¶й—ҙе’ҢжҲӘеҸ–ж—¶й•ҝиҝӣиЎҢеҲҮеүІ пјҢ жңҖеҗҺе°ҶиЈҒеүӘеҗҺзҡ„йҹіи§Ҷйў‘дҝЎжҒҜиҝӣиЎҢеҺӢзј©зј–з Ғ пјҢ еҶҚе°ҒиЈ…иҝӣmp4е®№еҷЁдёӯ пјҢ иҝҷж ·жҲ‘们зҡ„иЈҒеүӘзІҫеәҰд»Һз§’зә§иҜҜе·®йҷҚдҪҺеҲ°еҫ®з§’зә§иҜҜе·® пјҢ еӨ§еӨ§жҸҗй«ҳдәҶе®№й”ҷзҺҮ гҖӮ

и§Ҷйў‘еӨ„зҗҶ

и§Ҷйў‘еӨ„зҗҶжҳҜж•ҙдёӘи§Ҷйў‘иғҪеҠӣжңҖж ёеҝғзҡ„йғЁеҲҶ пјҢ дјҡж¶үеҸҠзЎ¬зј–и§Јз ҒпјҲйҒөеҫӘOpenMAXжЎҶжһ¶пјүгҖҒOpenGLгҖҒйҹійў‘еӨ„зҗҶзӯүзӣёе…іиғҪеҠӣ гҖӮ

дёӢеӣҫжҳҜи§Ҷйў‘еӨ„зҗҶзҡ„ж ёеҝғжөҒзЁӢ пјҢ дјҡе…Ҳе°Ҷйҹіи§Ҷйў‘еҒҡеҲҶзҰ» пјҢ 并иЎҢеӨ„зҗҶйҹіи§Ҷйў‘зҡ„зј–и§Јз Ғ пјҢ 并еҠ е…Ҙзү№ж•ҲеӨ„зҗҶ пјҢ жңҖеҗҺеҗҲжҲҗиҝӣдёҖдёӘmp4ж–Ү件дёӯ гҖӮ

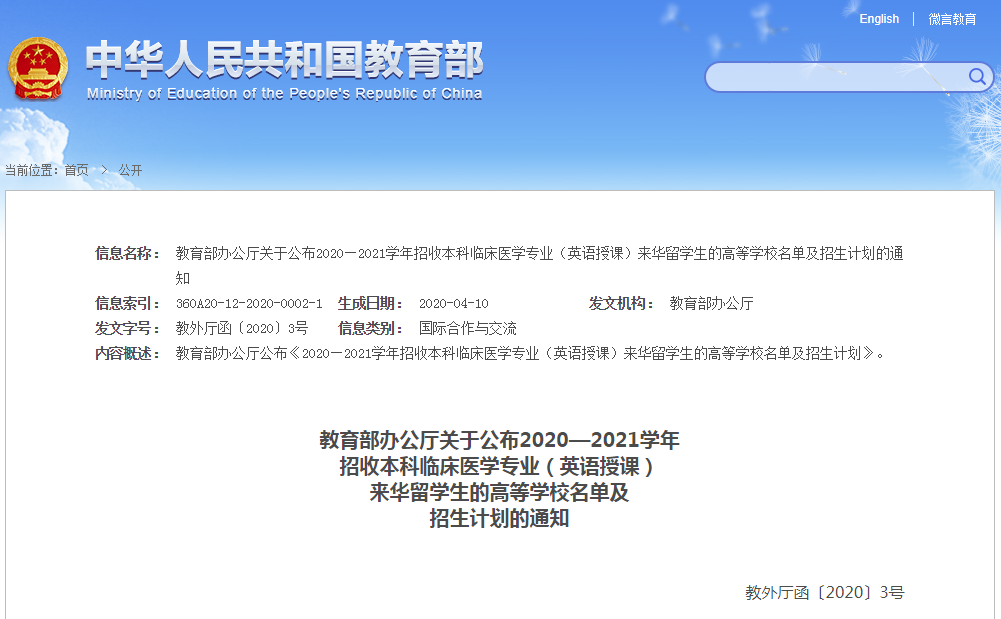

ж–Үз« жҸ’еӣҫ

еңЁе®һи·өиҝҮзЁӢдёӯ пјҢ жҲ‘们йҒҮеҲ°дәҶдёҖдәӣйңҖиҰҒзү№еҲ«жіЁж„Ҹзҡ„й—®йўҳ пјҢ жҜ”еҰӮејҖеҸ‘ж—¶йҒҮеҲ°зҡ„еқ‘ пјҢ дёҘйҮҚзҡ„е…је®№жҖ§й—®йўҳпјҲеҢ…жӢ¬зЎ¬д»¶е…је®№жҖ§е’Ңзі»з»ҹзүҲжң¬е…је®№жҖ§й—®йўҳпјүзӯү гҖӮдёӢйқўйҮҚзӮ№и®ІеҮ дёӘжңүд»ЈиЎЁжҖ§зҡ„й—®йўҳ гҖӮ

1. еҒ¶ж•°е®Ҫй«ҳзҡ„зј–и§Јз ҒеҷЁ

и§Ҷйў‘з»ҸиҝҮзј–з ҒеҗҺиҫ“еҮәзү№е®ҡе®Ҫй«ҳзҡ„и§Ҷйў‘ж–Ү件时еҮәзҺ°дәҶеҰӮдёӢй”ҷиҜҜ пјҢ дҝЎжҒҜйҮҢд»…жҸҗзӨәдәҶColorformatй”ҷиҜҜ пјҢ е…·дҪ“еҰӮдёӢпјҡ

ж–Үз« жҸ’еӣҫ

жҹҘйҳ…еӨ§йҮҸиө„ж–ҷ пјҢ д№ҹжІЎиғҪи§ЈйҮҠжё…жҘҡиҝҷдёӘејӮеёёзҡ„еӯҳеңЁ гҖӮеҹәдәҺж—Ҙеҝ—й”ҷиҜҜдҝЎжҒҜ пјҢ 并йҖҡиҝҮзі»з»ҹжәҗз Ғе®ҡдҪҚ пјҢ д№ҹеҸӘжҳҜеҸ‘зҺ°жҳҜдәҶе’Ңи®ҫзҪ®зҡ„еҸӮж•°дёҚе…је®№еҜјиҮҙзҡ„ гҖӮз»ҸиҝҮеҸҚеӨҚзҡ„иҜ•й”ҷ пјҢ жңҖеҗҺзЎ®и®ӨжҳҜйғЁеҲҶзј–и§Јз ҒеҷЁеҸӘж”ҜжҢҒеҒ¶ж•°зҡ„и§Ҷйў‘е®Ҫй«ҳ пјҢ жүҖд»ҘжҲ‘们еҜ№и§Ҷйў‘зҡ„е®Ҫй«ҳеҒҡдәҶеҒ¶ж•°йҷҗеҲ¶ гҖӮеј•иө·иҜҘй—®йўҳзҡ„ж ёеҝғд»Јз ҒеҰӮдёӢпјҡ

status_t ACodec::setupVideoEncoder(const char *mime, const sp<AMessage> &msg, sp<AMessage> &outputFormat, sp<AMessage> &inputFormat) { if (!msg->findInt32("color-format", &tmp)) { return INVALID_OPERATION; } OMX_COLOR_FORMATTYPE colorFormat = static_cast<OMX_COLOR_FORMATTYPE>(tmp); status_t err = setVideoPortFormatType( kPortIndexInput, OMX_VIDEO_CodingUnused, colorFormat); if (err != OK) { ALOGE("[%s] does not support color format %d", mComponentName.c_str(), colorFormat); return err; } .......}status_t ACodec::setVideoPortFormatType(OMX_U32 portIndex,OMX_VIDEO_CODINGTYPE compressionFormat, OMX_COLOR_FORMATTYPE colorFormat,bool usingNativeBuffers) { ...... for (OMX_U32 index = 0; index <= kMaxIndicesToCheck; ++index) { format.nIndex = index; status_t err = mOMX->getParameter( mNode, OMX_IndexParamVideoPortFormat, &format, sizeof(format)); if (err != OK) { return err; } ......}2. йўңиүІж јејҸ

жҲ‘们еңЁеӨ„зҗҶи§Ҷйў‘её§зҡ„ж—¶еҖҷ пјҢ дёҖејҖе§ӢиҺ·еҫ—зҡ„жҳҜд»ҺCameraиҜ»еҸ–еҲ°зҡ„еҹәжң¬зҡ„YUVж јејҸж•°жҚ® пјҢ еҰӮжһңз»ҷзј–з ҒеҷЁи®ҫзҪ®YUVеё§ж јејҸ пјҢ йңҖиҰҒиҖғиҷ‘YUVзҡ„йўңиүІж јејҸ гҖӮиҝҷжҳҜеӣ дёәYUVж №жҚ®е…¶йҮҮж ·жҜ”дҫӢ пјҢ UVеҲҶйҮҸзҡ„жҺ’еҲ—йЎәеәҸжңүеҫҲеӨҡз§ҚдёҚеҗҢзҡ„йўңиүІж јејҸ пјҢ Androidд№ҹж”ҜжҢҒдёҚеҗҢзҡ„YUVж јејҸ пјҢ еҰӮжһңйўңиүІж јејҸдёҚеҜ№ пјҢ дјҡеҜјиҮҙиҠұеұҸзӯүй—®йўҳ гҖӮ

3. 16дҪҚеҜ№йҪҗ

иҝҷд№ҹжҳҜзЎ¬зј–з ҒдёӯиҖҒз”ҹеёёи°Ҳзҡ„й—®йўҳдәҶ пјҢ еӣ дёәH264зј–з ҒйңҖиҰҒ16*16зҡ„зј–з Ғеқ—еӨ§е°Ҹ гҖӮеҰӮжһңдёҖејҖе§Ӣи®ҫзҪ®иҫ“еҮәзҡ„и§Ҷйў‘е®Ҫй«ҳжІЎжңүиҝӣиЎҢ16еӯ—иҠӮеҜ№йҪҗ пјҢ еңЁжҹҗдәӣи®ҫеӨҮпјҲеҚҺдёә пјҢ дёүжҳҹзӯүпјүе°ұдјҡеҮәзҺ°з»ҝиҫ№ пјҢ жҲ–иҖ…иҠұеұҸ гҖӮ

4. дәҢж¬ЎжёІжҹ“

4.1 и§Ҷйў‘ж—ӢиҪ¬

еңЁжңҖеҗҺзҡ„и§Ҷйў‘еӨ„зҗҶйҳ¶ж®ө пјҢ з”ЁжҲ·еҸҜд»Ҙе®һж—¶зҡ„зңӢеҲ°еҠ ж»Өй•ңеҗҺзҡ„и§Ҷйў‘ж•Ҳжһң гҖӮиҝҷе°ұйңҖиҰҒеҜ№еҺҹе§Ӣзҡ„и§Ҷйў‘её§иҝӣиЎҢдәҢж¬ЎеӨ„зҗҶ пјҢ 然еҗҺеңЁж’ӯж”ҫеҷЁзҡ„SurfaceдёҠжёІжҹ“ гҖӮйҰ–е…ҲжҲ‘们йңҖиҰҒOpenGL зҡ„жёІжҹ“зҺҜеўғпјҲйҖҡиҝҮOpenGLзҡ„еӣәжңүжөҒзЁӢеҲӣе»әпјү пјҢ жёІжҹ“зҺҜеўғе®ҢжҲҗеҗҺе°ұеҸҜд»ҘеҜ№и§Ҷйў‘зҡ„её§ж•°жҚ®иҝӣиЎҢдәҢж¬ЎеӨ„зҗҶдәҶ гҖӮйҖҡиҝҮSurfaceTextureзҡ„updateTexImageжҺҘеҸЈ пјҢ еҸҜе°Ҷи§Ҷйў‘жөҒдёӯжңҖж–°зҡ„её§ж•°жҚ®жӣҙж–°еҲ°еҜ№еә”зҡ„GLзә№зҗҶ пјҢ еҶҚж“ҚдҪңGLзә№зҗҶиҝӣиЎҢж»Өй•ңгҖҒеҠЁз”»зӯүеӨ„зҗҶ гҖӮеңЁеӨ„зҗҶи§Ҷйў‘её§ж•°жҚ®зҡ„ж—¶еҖҷ пјҢ йҰ–е…ҲйҒҮеҲ°зҡ„жҳҜи§’еәҰй—®йўҳ гҖӮеңЁжӯЈеёёж’ӯж”ҫдёӢпјҲдёҚеҲ©з”ЁOpenGLеӨ„зҗҶжғ…еҶөдёӢпјүйҖҡиҝҮи®ҫзҪ®TextureViewзҡ„и§’еәҰпјҲе’Ңи§Ҷйў‘зҡ„и§’еәҰеҒҡиҪ¬жҚўпјүе°ұеҸҜд»Ҙи§ЈеҶі пјҢ дҪҶжҳҜеҠ дәҶж»Өй•ңеҗҺиҝҷдёҖж–№жЎҲе°ұеӨұж•ҲдәҶ гҖӮеҺҹеӣ жҳҜи§Ҷйў‘зҡ„еҺҹе§Ӣж•°жҚ®з»ҸиҝҮзә№зҗҶеӨ„зҗҶеҶҚжёІжҹ“еҲ°SurfaceдёҠ пјҢ еҚ•зәҜи®ҫзҪ®TextureViewзҡ„и§’еәҰе°ұеӨұж•ҲдәҶ пјҢ и§ЈеҶіж–№жЎҲе°ұжҳҜеҜ№OpenGLдј е…Ҙзҡ„зә№зҗҶеқҗж ҮеҒҡзӣёеә”зҡ„ж—ӢиҪ¬пјҲдҫқжҚ®и§Ҷйў‘зҡ„жң¬иә«зҡ„и§’еәҰпјү гҖӮ

жҺЁиҚҗйҳ…иҜ»

- Android NDK-ж·ұе…ҘзҗҶи§ЈJNI

- AndroidеҰӮдҪ•дҪҝз”ЁжіЁи§ЈиҝӣиЎҢд»Јз ҒжЈҖжҹҘ

- жҠ–йҹі Android жҖ§иғҪдјҳеҢ–зі»еҲ—пјҡеҗҜеҠЁдјҳеҢ–д№ӢзҗҶи®әе’Ңе·Ҙе…·зҜҮ

- Androidзј©ж”ҫжүӢеҠҝзҡ„жЈҖжөӢ

- иҮӘеҠЁиҜҶеҲ« Android дёҚеҗҲзҗҶзҡ„еҶ…еӯҳеҲҶй…Қ

- AndroidйқўиҜ•йўҳйӣҶй”Ұд№Ӣ Service

- жҖҺж ·жҗӯй«ҳиҙЁйҮҸзҡ„AndroidйЎ№зӣ®жЎҶжһ¶пјҢжЎҶжһ¶зҡ„з»“жһ„е…·дҪ“жҸҸиҝ°пјҹ

- и°·жӯҢAndroid 12Lзҡ„йҖӮй…ҚжңәеһӢпјҢзңӢеҫ—жҲ‘们жңүзӮ№жҮө

- жө…и°ҲAndroidзұ»еҠ иҪҪеҷЁ

- Android 12жҺЁеҮәжӯЈејҸзүҲпјҒиҝҷж¬Ўзҡ„еҚҮзә§еҲ°еә•еҖјдёҚеҖјеҫ—жӣҙж–°е‘ўпјҹ

![[зҫҺеҘҪпјҢдёҖзӣҙеңЁиә«иҫ№]жғҠйӣ·пјҒ新科еӣӯзӨҫеҢәиў«вҖң黑科жҠҖвҖқеҠ жҢҒ](http://ttbs.guangsuss.com/image/b21683c8c829216f151c5ed38cf8dbb3)