6.6 循环支持向量机

Shi 等人 (2016a) 提出了循环支持向量机 (RSVM) , 利用循环神经网络 (RNN) 从输入序列中提取特征 , 用标准支持向量机 (SVM) 进行序列级目标识别 。

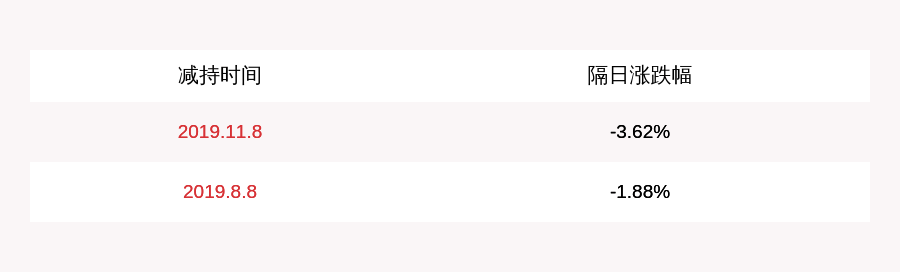

文章插图

7. 训练和优化技术

在本节中 , 我们将简要概述一些主要的技术 , 用于正则化和优化深度神经网络 (DNN) 。

7.1 Dropout

Srivastava 等人 (2014) 提出 Dropout , 以防止神经网络过拟合 。Dropout 是一种神经网络模型平均正则化方法 , 通过增加噪声到其隐藏单元 。在训练过程中 , 它会从神经网络中随机抽取出单元和连接 。Dropout 可以用于像 RBM (Srivastava et al. , 2014) 这样的图形模型中 , 也可以用于任何类型的神经网络 。最近提出的一个关于 Dropout 的改进是 Fraternal Dropout , 用于循环神经网络 (RNN) 。

7.2 Maxout

Goodfellow 等人 (2013) 提出 Maxout , 一种新的激活函数 , 用于 Dropout 。Maxout 的输出是一组输入的最大值 , 有利于 Dropout 的模型平均 。

7.3 Zoneout

Krueger 等人 (2016) 提出了循环神经网络 (RNN) 的正则化方法 Zoneout 。Zoneout 在训练中随机使用噪音 , 类似于 Dropout , 但保留了隐藏的单元而不是丢弃 。

7.4 深度残差学习

He 等人 (2015) 提出了深度残差学习框架 , 该框架被称为低训练误差的 ResNet 。

7.5 批归一化

Ioffe 和 Szegedy(2015) 提出了批归一化 , 通过减少内部协变量移位来加速深度神经网络训练的方法 。Ioffe(2017) 提出批重归一化 , 扩展了以前的方法 。

7.6 Distillation

Hinton 等人 (2015) 提出了将知识从高度正则化模型的集合 (即神经网络) 转化为压缩小模型的方法 。

7.7 层归一化

Ba 等人 (2016) 提出了层归一化 , 特别是针对 RNN 的深度神经网络加速训练 , 解决了批归一化的局限性 。

8. 深度学习框架

有大量的开源库和框架可供深度学习使用 。它们大多数是为 Python 编程语言构建的 。如 Theano、Tensorflow、PyTorch、PyBrain、Caffe、Blocks and Fuel 、CuDNN、Honk、ChainerCV、PyLearn2、Chainer,、torch 等 。

9. 深度学习的应用

在本节中 , 我们将简要地讨论一些最近在深度学习方面的杰出应用 。自深度学习 (DL) 开始以来 , DL 方法以监督、非监督、半监督或强化学习的形式被广泛应用于各个领域 。从分类和检测任务开始 , DL 应用正在迅速扩展到每一个领域 。

文章插图

例如:

- 图像分类与识别

- 视频分类

- 序列生成

- 缺陷分类

- 文本、语音、图像和视频处理

- 文本分类

- 语音处理

- 语音识别和口语理解

- 文本到语音生成

- 查询分类

- 句子分类

- 句子建模

- 词汇处理

- 预选择

- 文档和句子处理

- 生成图像文字说明

- 照片风格迁移

- 自然图像流形

- 图像着色

- 图像问答

- 生成纹理和风格化图像

- 视觉和文本问答

- 视觉识别和描述

- 目标识别

- 文档处理

- 人物动作合成和编辑

- 歌曲合成

- 身份识别

- 人脸识别和验证

- 视频动作识别

- 人类动作识别

- 动作识别

- 分类和可视化动作捕捉序列

- 手写生成和预测

- 自动化和机器翻译

- 命名实体识别

- 移动视觉

- 对话智能体

- 调用遗传变异

- 癌症检测

- X 射线 CT 重建

- 癫痫发作预测

- 硬件加速

- 机器人

Deng 和 Yu(2014) 提供了 DL 在语音处理、信息检索、目标识别、计算机视觉、多模态、多任务学习等领域应用的详细列表 。

使用深度强化学习 (Deep Reinforcement Learning, DRL) 来掌握游戏已经成为当今的一个热门话题 。每到现在 , 人工智能机器人都是用 DNN 和 DRL 创建的 , 它们在战略和其他游戏中击败了人类世界冠军和象棋大师 , 从几个小时的训练开始 。例如围棋的 AlphaGo 和 AlphaGo Zero 。

10. 讨论

尽管深度学习在许多领域取得了巨大的成功 , 但它还有很长的路要走 。还有很多地方有待改进 。至于局限性 , 例子也是相当多的 。例如:Nguyen 等人表明深度神经网络(DNN)在识别图像时容易被欺骗 。还有其他问题 , 如 Yosinski 等人提出的学习的特征可迁移性 。Huang 等人提出了一种神经网络攻击防御的体系结构 , 认为未来的工作需要防御这些攻击 。Zhang 等人则提出了一个理解深度学习模型的实验框架 , 他们认为理解深度学习需要重新思考和概括 。

推荐阅读

- 太极扇子舞的好处适合中老年人的太极扇子舞

- 晚上适合喝红茶 但喝茶应适当

- 适合电脑族的几款养生茶

- 男生怎么选到适合自己的眼镜?看这边

- 抖音垫肩神器适合胖人吗

- 金骏眉茶的茶性温,适合女性喝!

- 任何款紫砂都适合铁观音

- 浙江省|2022 年应届生如何找到适合自己的工作?

- 一般家用电饼铛的大小是多少 电饼铛直径多少适合家用

- 花茶并非人人都适合