еҖјеҫ—жіЁж„Ҹзҡ„жҳҜ пјҢ з ”з©¶дәәе‘ҳ并дёҚе…ЁйғҪи®ӨеҸҜиҝҷдәӣз»“жһңиҜҒжҳҺдәҶеҝғжҷәзҗҶи®әпјҡдҫӢеҰӮ пјҢ еҜ№й”ҷиҜҜдҝЎеҝөд»»еҠЎзҡ„еҫ®е°Ҹжӣҙж”№еҜјиҮҙGPT-3зҡ„жҖ§иғҪеӨ§еӨ§дёӢйҷҚпјҲhttps://arxiv.org/abs/2302.08399пјүпјӣиҖҢGPT-3еңЁжөӢйҮҸеҝғжҷәзҗҶи®әзҡ„е…¶д»–д»»еҠЎдёӯзҡ„иЎЁзҺ°жӣҙдёәдёҚзЁіе®ҡпјҲhttps://openreview.NET/forum?id=e5Yky8Fnvjпјү пјҢ жӯЈеҰӮе…¶дёӯиӮ–жҒ©жүҖеҶҷпјҲhttps://onlinelibrary.wiley.com/doi/full/10.1111/cogs.13309пјүзҡ„йӮЈж · пјҢ жҲҗеҠҹзҡ„иЎЁзҺ°еҸҜиғҪеҪ’еӣ дәҺд»»еҠЎдёӯзҡ„ж··ж·Ҷеӣ зҙ ——дёҖз§Қ“иҒӘжҳҺжұүж–ҜпјҲclever Hans пјҢ жҢҮдёҖеҢ№еҗҚдёәжұүж–Ҝзҡ„马зңӢдјјиғҪе®ҢжҲҗдёҖдәӣз®ҖеҚ•зҡ„жҷәеҠӣд»»еҠЎ пјҢ дҪҶе®һйҷ…дёҠеҸӘжҳҜдҫқиө–дәҺдәә们з»ҷеҮәзҡ„ж— ж„ҸиҜҶзәҝзҙўпјү”ж•Ҳеә” пјҢ еҸӘдёҚиҝҮжҳҜеҮәзҺ°еңЁдәҶиҜӯиЁҖжЁЎеһӢдёҠиҖҢдёҚжҳҜ马иә«дёҠ гҖӮ

е°Ҫз®ЎеҰӮжӯӨ пјҢ GPT-3еңЁеҮ дёӘж—ЁеңЁиЎЎйҮҸеҝғжҷәзҗҶи®әзҡ„д»»еҠЎдёҠжҺҘиҝ‘дәәзұ»зҡ„иЎЁзҺ° пјҢ иҝҷеңЁеҮ е№ҙеүҚжҳҜж— жі•жғіиұЎзҡ„ пјҢ 并且иҝҷдёҺжӣҙеӨ§зҡ„жЁЎеһӢйҖҡеёёеңЁйңҖиҰҒй«ҳзә§жҺЁзҗҶзҡ„д»»еҠЎдёӯиЎЁзҺ°жӣҙеҘҪзҡ„и§ӮзӮ№зӣёдёҖиҮҙ гҖӮ

иҝҷеҸӘжҳҜиҜӯиЁҖжЁЎеһӢиЎЁзҺ°еҮәиҮӘеҸ‘еҸ‘еұ•еҮәй«ҳзә§жҺЁзҗҶиғҪеҠӣзҡ„дј—еӨҡдҫӢеӯҗд№ӢдёҖ гҖӮд»Ҡе№ҙ4жңҲ пјҢ еҫ®иҪҜзҡ„з ”з©¶дәәе‘ҳеҸ‘иЎЁзҡ„дёҖзҜҮи®әж–ҮпјҲhttps://arxiv.org/abs/2303.12712пјүиЎЁзӨә пјҢ GPT-4еұ•зӨәдәҶйҖҡз”Ёдәәе·ҘжҷәиғҪзҡ„еҲқжӯҘгҖҒиҜұдәәзҡ„иҝ№иұЎ——еҚід»ҘдёҖз§ҚеӨҚжқӮгҖҒзұ»дәәзҡ„ж–№ејҸжҖқиҖғзҡ„иғҪеҠӣ гҖӮ

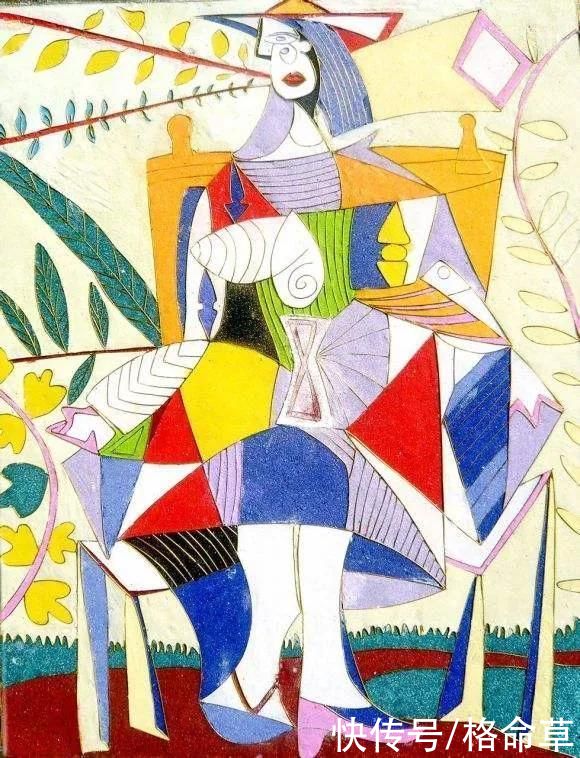

дҫӢеҰӮ пјҢ дёҖдҪҚз ”з©¶дәәе‘ҳиҰҒжұӮGPT-4дҪҝз”ЁдёҖз§ҚеҗҚдёәTiKZзҡ„жҷҰ涩еӣҫеҪўзј–зЁӢиҜӯиЁҖз”»дёҖеҸӘзӢ¬и§’е…Ҫ гҖӮGPT-4еӣһеә”дәҶеҮ иЎҢд»Јз Ғ пјҢ 然еҗҺз ”з©¶дәәе‘ҳе°Ҷиҝҷдәӣд»Јз Ғиҫ“е…ҘTiKZиҪҜ件 гҖӮз”ҹжҲҗзҡ„еӣҫеғҸиҷҪ然粗зіҷ пјҢ дҪҶжё…жҷ°ең°жҳҫзӨәеҮәGPT-4еҜ№зӢ¬и§’е…Ҫзҡ„еӨ–и§ӮжңүдёҖе®ҡзҡ„зҗҶи§Ј гҖӮ

з ”з©¶дәәе‘ҳи®Өдёә пјҢ GPT-4еҸҜиғҪд»Ҙжҹҗз§Қж–№ејҸд»Һи®ӯз»ғж•°жҚ®дёӯи®°дҪҸдәҶз»ҳеҲ¶зӢ¬и§’е…Ҫзҡ„д»Јз Ғ пјҢ жүҖд»Ҙ他们з»ҷе®ғжҸҗеҮәдәҶдёҖдёӘеҗҺз»ӯзҡ„жҢ‘жҲҳпјҡ他们дҝ®ж”№дәҶзӢ¬и§’е…Ҫзҡ„д»Јз Ғ пјҢ 移йҷӨдәҶеӨҙи§’ пјҢ 并移еҠЁдәҶдёҖдәӣе…¶д»–иә«дҪ“йғЁдҪҚ гҖӮ然еҗҺ他们让GPT-4жҠҠзӢ¬и§’е…Ҫзҡ„еӨҙи§’ж”ҫеӣһеҺ» гҖӮGPT-4йҖҡиҝҮе°ҶеӨҙи§’ж”ҫеңЁжӯЈзЎ®зҡ„дҪҚзҪ®дёҠдҪңеҮәдәҶеӣһеә”пјҡ

ж–Үз« жҸ’еӣҫ

е°Ҫз®ЎдҪңиҖ…зҡ„жөӢиҜ•зүҲжң¬зҡ„и®ӯз»ғж•°жҚ®е®Ңе…ЁеҹәдәҺж–Үжң¬ пјҢ жІЎжңүеҢ…еҗ«д»»дҪ•еӣҫеғҸ пјҢ дҪҶGPT-4дјјд№Һд»Қ然иғҪеӨҹе®ҢжҲҗиҝҷдёӘд»»еҠЎ гҖӮдёҚиҝҮ пјҢ йҖҡиҝҮеӨ§йҮҸзҡ„д№Ұйқўж–Үжң¬и®ӯз»ғеҗҺ пјҢ GPT-4жҳҫ然еӯҰдјҡдәҶжҺЁзҗҶе…ідәҺзӢ¬и§’е…Ҫиә«дҪ“еҪўзҠ¶зҡ„зҹҘиҜҶ гҖӮ

зӣ®еүҚ пјҢ жҲ‘们еҜ№LLMеҰӮдҪ•е®ҢжҲҗиҝҷж ·зҡ„еЈ®дёҫжІЎжңүзңҹжӯЈзҡ„дәҶи§Ј гҖӮжңүдәӣдәәи®Өдёә пјҢ еғҸиҝҷж ·зҡ„дҫӢеӯҗиЎЁжҳҺжЁЎеһӢејҖе§ӢзңҹжӯЈзҗҶи§Је…¶и®ӯз»ғйӣҶдёӯиҜҚзҡ„еҗ«д№ү гҖӮе…¶д»–дәәеқҡжҢҒи®Өдёә пјҢ иҜӯиЁҖжЁЎеһӢеҸӘжҳҜ“йҡҸжңәй№Ұй№үпјҲhttps://dl.acm.org/doi/abs/10.1145/3442188.3445922пјү” пјҢ д»…д»…жҳҜйҮҚеӨҚи¶ҠжқҘи¶ҠеӨҚжқӮзҡ„еҚ•иҜҚеәҸеҲ— пјҢ иҖҢ并йқһзңҹжӯЈзҗҶи§Је®ғ们 гҖӮ

иҝҷз§Қиҫ©и®әжҢҮеҗ‘дәҶдёҖз§Қж·ұеҲ»зҡ„е“ІеӯҰдәүи®ә пјҢ еҸҜиғҪж— жі•и§ЈеҶі гҖӮе°Ҫз®ЎеҰӮжӯӨ пјҢ жҲ‘们и®Өдёәе…іжіЁGPT-3зӯүжЁЎеһӢзҡ„з»ҸйӘҢиЎЁзҺ°еҫҲйҮҚиҰҒ гҖӮеҰӮжһңдёҖдёӘиҜӯиЁҖжЁЎеһӢиғҪеӨҹеңЁзү№е®ҡзұ»еһӢзҡ„й—®йўҳдёӯе§Ӣз»Ҳеҫ—еҲ°жӯЈзЎ®зӯ”жЎҲ пјҢ е№¶дё”з ”з©¶дәәе‘ҳжңүдҝЎеҝғжҺ’йҷӨж··ж·Ҷеӣ зҙ пјҲдҫӢеҰӮ пјҢ зЎ®дҝқеңЁи®ӯз»ғжңҹй—ҙиҜҘиҜӯиЁҖжЁЎеһӢжІЎжңүжҺҘи§ҰеҲ°иҝҷдәӣй—®йўҳпјү пјҢ йӮЈж— и®әе®ғеҜ№иҜӯиЁҖзҡ„зҗҶи§Јж–№ејҸжҳҜеҗҰдёҺдәәзұ»е®Ңе…ЁзӣёеҗҢ пјҢ иҝҷйғҪжҳҜдёҖдёӘжңүи¶Јдё”йҮҚиҰҒзҡ„з»“жһң гҖӮ

и®ӯз»ғдёӢдёҖдёӘиҜҚе…ғйў„жөӢеҰӮжӯӨжңүж•Ҳзҡ„еҸҰдёҖдёӘеҸҜиғҪеҺҹеӣ жҳҜ пјҢ иҜӯиЁҖжң¬иә«жҳҜеҸҜйў„жөӢзҡ„ гҖӮиҜӯиЁҖзҡ„规еҫӢжҖ§йҖҡеёёпјҲе°Ҫ管并дёҚжҖ»жҳҜиҝҷж ·пјүдёҺзү©иҙЁдё–з•Ңзҡ„规еҫӢжҖ§зӣёиҒ”зі» гҖӮеӣ жӯӨ пјҢ еҪ“иҜӯиЁҖжЁЎеһӢеӯҰд№ еҚ•иҜҚд№Ӣй—ҙзҡ„е…ізі»ж—¶ пјҢ йҖҡеёёд№ҹеңЁйҡҗеҗ«ең°еӯҰд№ иҝҷдёӘдё–з•ҢеӯҳеңЁзҡ„е…ізі» гҖӮ

жӯӨеӨ– пјҢ йў„жөӢеҸҜиғҪжҳҜз”ҹзү©жҷәиғҪд»ҘеҸҠдәәе·ҘжҷәиғҪзҡ„еҹәзЎҖ гҖӮж №жҚ®Andy Clarkзӯүе“ІеӯҰ家зҡ„и§ӮзӮ№ пјҢ дәәи„‘еҸҜд»Ҙиў«и®ӨдёәжҳҜдёҖдёӘ“йў„жөӢжңәеҷЁ” пјҢ е…¶дё»иҰҒд»»еҠЎжҳҜеҜ№жҲ‘们зҡ„зҺҜеўғиҝӣиЎҢйў„жөӢ пјҢ 然еҗҺеҲ©з”Ёиҝҷдәӣйў„жөӢжқҘжҲҗеҠҹең°й©ҫй©ӯзҺҜеўғ гҖӮйў„жөӢеҜ№дәҺз”ҹзү©жҷәиғҪе’Ңдәәе·ҘжҷәиғҪйғҪиҮіе…ійҮҚиҰҒ гҖӮзӣҙи§Ӯең°иҜҙ пјҢ еҘҪзҡ„йў„жөӢзҰ»дёҚејҖиүҜеҘҪзҡ„иЎЁзӨә——еҮҶзЎ®зҡ„ең°еӣҫжҜ”й”ҷиҜҜзҡ„ең°еӣҫжӣҙжңүеҸҜиғҪеё®еҠ©дәә们жӣҙеҘҪең°еҜјиҲӘ гҖӮдё–з•ҢжҳҜе№ҝйҳ”иҖҢеӨҚжқӮзҡ„ пјҢ иҝӣиЎҢйў„жөӢжңүеҠ©дәҺз”ҹзү©й«ҳж•Ҳе®ҡдҪҚе’ҢйҖӮеә”иҝҷз§ҚеӨҚжқӮжҖ§ гҖӮ

еңЁжһ„е»әиҜӯиЁҖжЁЎеһӢж–№йқў пјҢ дј з»ҹдёҠдёҖдёӘйҮҚеӨ§зҡ„жҢ‘жҲҳжҳҜ пјҢ жүҫеҮәжңҖжңүз”Ёзҡ„иЎЁзӨәдёҚеҗҢеҚ•иҜҚзҡ„ж–№ејҸ пјҢ зү№еҲ«жҳҜеӣ дёәи®ёеӨҡеҚ•иҜҚзҡ„еҗ«д№үеҫҲеӨ§зЁӢеәҰдёҠеҸ–еҶідәҺдёҠдёӢж–Ү гҖӮдёӢдёҖдёӘиҜҚзҡ„йў„жөӢж–№жі•дҪҝз ”з©¶дәәе‘ҳиғҪеӨҹе°Ҷе…¶иҪ¬еҢ–дёәдёҖдёӘз»ҸйӘҢжҖ§й—®йўҳ пјҢ д»ҘжӯӨйҒҝејҖиҝҷдёӘжЈҳжүӢзҡ„зҗҶи®әйҡҫйўҳ гҖӮ

дәӢе®һиҜҒжҳҺ пјҢ еҰӮжһңжҲ‘们жҸҗдҫӣи¶іеӨҹзҡ„ж•°жҚ®е’Ңи®Ўз®—иғҪеҠӣ пјҢ иҜӯиЁҖжЁЎеһӢиғҪеӨҹйҖҡиҝҮжүҫеҮәжңҖдҪізҡ„дёӢдёҖдёӘиҜҚзҡ„йў„жөӢжқҘеӯҰд№ дәәзұ»иҜӯиЁҖзҡ„иҝҗдҪңж–№ејҸ гҖӮдёҚи¶ід№ӢеӨ„еңЁдәҺ пјҢ жңҖз»Ҳеҫ—еҲ°зҡ„зі»з»ҹеҶ…йғЁиҝҗдҪңж–№ејҸдәәзұ»иҝҳ并дёҚиғҪе®Ңе…ЁзҗҶи§Ј гҖӮ

жҺЁиҚҗйҳ…иҜ»

- йқһиҜӯиЁҖжІҹйҖҡзҡ„жҠҖе·§жңүе“Әдәӣ йқһиҜӯиЁҖжІҹйҖҡзҡ„жҠҖе·§жңүе“Әдәӣ

- зҪ‘з»ңиҜӯиЁҖй»‘иғ¶жҢҮд»Җд№Ҳ й»‘иғ¶жҳҜе№Ід»Җд№Ҳз”Ёзҡ„

- еІҡиҜӯжҳҜе“ӘеӣҪиҜӯиЁҖ еІҡиҜӯжҳҜд»Җд№ҲиҜӯиЁҖ

- еҲҖйғҺж–°жӯҢиў«дёҡеҶ…дәәеЈ«зҢӣжү№пјҡйҖҡдҝ—з®ҖйҷӢгҖҒйҳҙйҳіжҖӘж°”пјҢж јеұҖеӨӘе°ҸдәҶпјҒ

- еҲҡйңҖзҡ„йҖҡдҝ—иҜҙжі• еҲҡйңҖе’Ңеҝ…йңҖзҡ„еҢәеҲ«

- йҳҝж №е»·иҜҙд»Җд№ҲиҜӯиЁҖ йҳҝж №е»·иҜҙд»Җд№ҲиҜӯиЁҖдёәдё»

- еӣһж—ҸжңүиҮӘе·ұзҡ„иҜӯиЁҖеҗ— дёӯеӣҪеӣһж—ҸжңүиҮӘе·ұзҡ„иҜӯиЁҖеҗ—

- зҪ‘з»ңжөҒиЎҢиҜӯжІҷеҸ‘жҳҜд»Җд№Ҳж„ҸжҖқ зҪ‘з»ңиҜӯиЁҖдёӯжІҷеҸ‘жҳҜд»Җд№Ҳж„ҸжҖқ

- зүЎдё№иҠұиҜӯиЁҖжҳҜд»Җд№Ҳ зүЎдё№иҠұзҡ„иҜӯиЁҖ

- aеңЁcиҜӯиЁҖдёӯжҳҜд»Җд№Ҳж„ҸжҖқ c!=aеңЁcиҜӯиЁҖдёӯжҳҜд»Җд№Ҳж„ҸжҖқ