жӢ“жү‘ECCV 2020 | д»ҺдёҖз§ҚжӢ“жү‘и§Ҷи§’жқҘдјҳеҢ–зҘһз»ҸзҪ‘з»ңзҡ„иҝһйҖҡжҖ§зҡ„и§ЈиҜ»

жң¬ж–ҮжҸ’еӣҫ

жң¬ж–ҮжҳҜи®Ўз®—жңәи§Ҷи§үйўҶеҹҹйЎ¶зә§дјҡи®® ECCV 2020 е…ҘйҖүи®әж–ҮгҖҠLearning Connectivity of Neural Networks from a Topological PerspectiveгҖӢзҡ„и§ЈиҜ» гҖӮ

дҪңиҖ… | иўҒ еқӨ

зј–иҫ‘ | йқ’ жҡ®

еңЁECCV 2020дёҠ пјҢ е•ҶжұӨз ”з©¶йҷўж·ұеәҰеӯҰд№ дёӯй—ҙ件组жҸҗеҮәзҡ„жӢ“жү‘и§Ҷи§’дёәеҲҶжһҗзҘһз»ҸзҪ‘з»ңзҡ„дјҳеҢ–иҝҮзЁӢжҸҗдҫӣдәҶдёҖз§Қж–°зҡ„жҖқи·Ҝ гҖӮ

еңЁи®ҫи®ЎзҘһз»ҸзҪ‘з»ңзҡ„ж·ұеәҰгҖҒеҚ·з§Ҝзұ»еһӢгҖҒеҪ’дёҖеҢ–еұӮе’ҢйқһзәҝжҖ§еұӮд№ӢеӨ– пјҢ жҲ‘们жҸҗеҮәеҜ№зҘһз»ҸзҪ‘з»ңзҡ„жӢ“жү‘иҝһжҺҘиҝӣиЎҢдјҳеҢ– пјҢ жқҘеҸ–д»Јд»ҘеҫҖзҡ„е ҶеҸ жҲ–жүӢе·Ҙи®ҫи®Ўзҡ„иҝһжҺҘж–№ејҸ гҖӮ йҖҡиҝҮе°ҶзҪ‘з»ңиЎЁзӨәдёәжңүеҗ‘ж— зҺҜеӣҫ пјҢ 并еҗ‘иҫ№иөӢдәҲеҸҜеӯҰд№ зҡ„жқғйҮҚжқҘиЎЁзӨәиҝһжҺҘзҡ„йҮҚиҰҒзЁӢеәҰ гҖӮ ж•ҙдёӘдјҳеҢ–иҝҮзЁӢеҸҜд»ҘйҖҡиҝҮеҸҜеҫ®еҲҶзҡ„ж–№ејҸиҝӣиЎҢ гҖӮ иҝӣдёҖжӯҘең° пјҢ жҲ‘们еҜ№иҝһжҺҘзҡ„еҲҶеёғж·»еҠ йўқеӨ–зҡ„зЁҖз–ҸзәҰжқҹ пјҢ дҪҝеҫ—йҮҚиҰҒзҡ„иҝһжҺҘеҫ—д»Ҙдҝқз•ҷ пјҢ 移йҷӨдёҚйҮҚиҰҒзҡ„иҝһжҺҘ пјҢ иҝӣдёҖжӯҘжҸҗеҚҮзҪ‘з»ңзҡ„жҖ§иғҪе’ҢжіӣеҢ–иғҪеҠӣ гҖӮ иҝҷз§ҚдјҳеҢ–ж–№ејҸеҸҜд»ҘеҫҲеҘҪзҡ„е’ҢзҺ°жңүзҡ„зҪ‘з»ңз»“жһ„иҝӣиЎҢз»“еҗҲ гҖӮ е®һйӘҢз»“жһңиЎЁжҳҺдјҳеҢ–еҫ—еҲ°зҡ„иҝһйҖҡж–№ејҸи¶…иҝҮдәҶдј з»ҹзҡ„еҹәдәҺ规еҲҷи®ҫи®ЎиҝһжҺҘ пјҢ еҢ…жӢ¬йҡҸжңәзҡ„гҖҒж®Ӣе·®зҡ„е’Ңе®Ңе…Ёеӣҫзҡ„ гҖӮ еңЁдёҚйўқеӨ–еўһеҠ иҝҮеӨҡеҸӮж•°йҮҸе’Ңи®Ўз®—йҮҸзҡ„еҹәзЎҖдёҠ пјҢ еңЁImageNetеӣҫеғҸеҲҶзұ»е’ҢCOCOзӣ®ж ҮжЈҖжөӢдёҠеҸ–еҫ—дәҶжҳҺжҳҫзҡ„жҸҗеҚҮ гҖӮ

1

з®Җд»Ӣе’ҢеҠЁжңә

ж·ұеәҰеӯҰд№ жҲҗеҠҹең°е°Ҷзү№еҫҒе·ҘзЁӢд»ҺжүӢе·Ҙи®ҫи®ЎиҪ¬з§»еҲ°иҮӘеҠЁеӯҰд№ гҖӮ иҝҷж Үеҝ—зқҖд»Һж ·жң¬еҲ°зү№еҫҒзҡ„жҳ е°„еҸҜд»Ҙж №жҚ®дёҚеҗҢзҡ„д»»еҠЎжқҘиҝӣиЎҢдјҳеҢ–еӯҰд№ гҖӮ дҪңдёәдёҖз§Қи¶ӢеҠҝ пјҢ еҜ»жүҫжңүж•Ҳзҡ„зҘһз»ҸзҪ‘з»ңз»“жһ„жҳҜдёҖдёӘйҮҚиҰҒдё”е…·жңүе®һйҷ…д»·еҖјзҡ„ж–№еҗ‘ гҖӮ дҪҶжҳҜз»“жһ„зҡ„и®ҫи®Ўдҫқж—§е……ж»ЎжҢ‘жҲҳдё”иҖ—ж—¶ гҖӮ йғЁеҲҶз ”з©¶е·ҘдҪңе…іжіЁдәҺзҪ‘з»ңзҡ„ж·ұеәҰгҖҒеҚ·з§Ҝзҡ„зұ»еһӢгҖҒеҪ’дёҖеҢ–е’ҢйқһзәҝжҖ§ж“ҚдҪңзӯү гҖӮ еңЁиҝҷдәӣз»ҙеәҰд№ӢеӨ– пјҢ д№ҹжңүдёҖдәӣе·ҘдҪңе°қиҜ•еңЁзҪ‘з»ңзҡ„жӢ“жү‘иҝһжҺҘдёҠиҝӣиЎҢж”№иҝӣ гҖӮ д»ҺVGGNetгҖҒGoogleNetгҖҒHighwayеҲ°ResNetгҖҒMobileNet-v2гҖҒShuffleNet пјҢ зҪ‘з»ңзҡ„жӢ“жү‘иҝһжҺҘд»Һе№іеҺҹжӢ“жү‘еҸ‘еұ•еҲ°ж®Ӣе·®жӢ“жү‘ пјҢ дёҖе®ҡзЁӢеәҰдёҠзј“и§ЈдәҶзҪ‘з»ңеҠ ж·ұеёҰжқҘзҡ„жўҜеәҰж¶ҲеӨұе’ҢзҲҶзӮёй—®йўҳ гҖӮ дёҚеҗҢдәҺиҝҷдәӣзӣёеҜ№зЁҖз–Ҹзҡ„иҝһжҺҘеҪўејҸ пјҢ DenseNetжҸҗеҮәе°ҶеұӮдёҺеұӮд№Ӣй—ҙе…ЁйғЁиҝһжҺҘеӨҚз”Ёзү№еҫҒиЎЁзӨә гҖӮ зҺ°жңүзҡ„дёҖдәӣзҪ‘з»ңз»“жһ„жҗңзҙўпјҲNASпјүж–№жі•д№ҹе°қиҜ•иҝӣиЎҢиҝһжҺҘж–№ејҸзҡ„жҗңзҙў гҖӮ еңЁдёҖе®ҡзЁӢеәҰдёҠ пјҢ иҝҷдәӣжӢ“жү‘еұӮйқўзҡ„ж”№иҝӣеҸҚжҳ дәҶжӢ“жү‘иҝһжҺҘеҜ№дјҳеҢ–иҝҮзЁӢзҡ„еҪұе“Қ гҖӮ дҪҶжҳҜдёәдәҶе№іиЎЎи®ҫи®ЎжҲҗжң¬е’ҢжҖ§иғҪ пјҢ иҝҷдәӣзҪ‘з»ңеӨ§еӨҡйҮҮз”Ёе ҶеҸ зҡ„ж–№ејҸжқҘжһ„е»әжңҖз»Ҳзҡ„з»“жһ„ пјҢ дёҖе®ҡзЁӢеәҰдёҠйҷҗеҲ¶дәҶжӢ“жү‘зҡ„еҸҜиғҪжҖ§ гҖӮ еӣ жӯӨ пјҢ жҲ‘们жҖқиҖғпјҡзҘһз»ҸзҪ‘з»ңзҡ„иҝһйҖҡжҖ§еҸҜд»Ҙиў«дјҳеҢ–еҗ—пјҹеҗҲйҖӮзҡ„ж–№жі•жҳҜд»Җд№Ҳпјҹ

2

зҘһз»ҸзҪ‘з»ңзҡ„жӢ“жү‘и§Ҷи§’

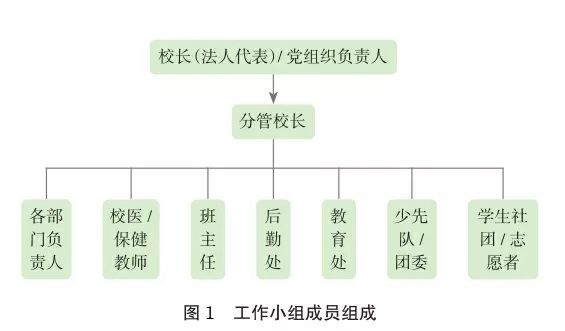

дёәдәҶеӣһзӯ”иҝҷдәӣ пјҢ жҲ‘们жҸҗеҮәдёҖз§Қж–°зҡ„жӢ“жү‘и§Ҷи§’жқҘиЎЁиҫҫеҲҶжһҗзҺ°жңүзҡ„зҪ‘з»ңз»“жһ„ гҖӮ еҰӮеӣҫ1жүҖзӨә пјҢ зҪ‘з»ңиў«иЎЁзӨәдёәжңүеҗ‘ж— зҺҜеӣҫпјҲDAGпјү пјҢ е…¶дёӯзү№еҫҒиһҚеҗҲгҖҒеҚ·з§Ҝи®Ўз®—гҖҒеҪ’дёҖеҢ–е’ҢйқһзәҝжҖ§зӯүзү№еҫҒи®Ўз®—иў«иЎЁзӨәдёәиҠӮзӮ№ пјҢ еұӮдёҺеұӮд№Ӣй—ҙзҡ„иҝһжҺҘиў«иЎЁзӨәдёәиҫ№ пјҢ еҸҚжҳ дҝЎжҒҜжөҒзҡ„дј йҖ’ гҖӮ еӣҫ1з»ҷеҮәдәҶж®Ӣе·®жӢ“жү‘иҝһжҺҘжүҖеҜ№еә”зҡ„жӢ“жү‘еҪўејҸ пјҢ жҲ‘们йҰ–ж¬Ўеұ•зӨәдәҶж®Ӣе·®зҡ„жӢ“жү‘иҝһжҺҘжҳҜдёҖз§ҚзӣёеҜ№зЁ еҜҶзҡ„иҝһжҺҘеҪўејҸ пјҢ еҪ“ж®Ӣе·®зҡ„й—ҙйҡ”дёә1ж—¶ пјҢ зҪ‘з»ңеҸҜд»Ҙиў«иЎЁзӨәдёәе®Ңе…ЁеӣҫпјҲcomplete graphпјү пјҢ еҚіеҗ„дёӘиҠӮзӮ№д№Ӣй—ҙеқҮжңүиҫ№иҝһжҺҘ гҖӮ жүҖжңүиҠӮзӮ№еҸҜд»ҘзӣҙжҺҘд»Һиҫ“е…ҘиҺ·еҸ–зү№еҫҒ пјҢ д»Һиҫ“еҮәиҺ·еҫ—жўҜеәҰжӣҙж–° пјҢ иҝҷеңЁдёҖе®ҡзЁӢеәҰдёҠи§ЈйҮҠдәҶж®Ӣе·®иҝһжҺҘиғҪеӨҹжңүж•Ҳзҡ„еҺҹеӣ гҖӮ

жң¬ж–ҮжҸ’еӣҫ

ж•°еӯҰеҪўејҸдёҠ пјҢ жҲ‘们е°ҶжӢ“жү‘и§Ҷи§’дёӢзҡ„зҪ‘з»ңз»“жһ„иЎЁзӨәдёәеӣҫ

пјҢ е…¶дёӯиЎЁзӨәиҠӮзӮ№зҡ„йӣҶеҗҲ пјҢ иЎЁзӨәиҫ№зҡ„йӣҶеҗҲ гҖӮ еңЁеӣҫдёӯзҡ„жҜҸдёҖдёӘиҠӮзӮ№иҝӣиЎҢзү№еҫҒеҸҳжҚўж“ҚдҪң пјҢ еҸӮж•°иЎЁзӨәдёә пјҢ е…¶дёӯиЎЁзӨәиҠӮзӮ№зҡ„жӢ“жү‘йЎәеәҸ гҖӮ еҗҢж—¶

иЎЁзӨәд»ҺиҠӮзӮ№еҲ°иҠӮзӮ№зҡ„иҫ№ пјҢ е…¶дёӯеҸҚжҳ дәҶиҝһжҺҘзҡ„йҮҚиҰҒзЁӢеәҰ гҖӮ еңЁеүҚеҗ‘и®Ўз®—зҡ„иҝҮзЁӢдёӯ пјҢ жҜҸдёӘиҠӮзӮ№д»ҺеӯҳеңЁиҝһжҺҘзҡ„еүҚеәҸиҠӮзӮ№иҺ·еҫ—зү№еҫҒиҫ“е…Ҙ пјҢ 然еҗҺз»ҸиҝҮеҸҳжҚўеҫ—еҲ°зү№еҫҒ гҖӮ д№ӢеҗҺиў«иҫ“йҖҒеҲ°еӯҳеңЁиҝһжҺҘзҡ„еҗҺз»ӯиҠӮзӮ№дёӯ пјҢ иҠӮзӮ№зҡ„ж“ҚдҪңеҸҜд»Ҙиў«иЎЁзӨәдёәпјҡ

еңЁдёҖдёӘеӣҫдёӯ пјҢ 第дёҖдёӘиҠӮзӮ№иў«жҢҮе®ҡдёәиҫ“е…ҘиҠӮзӮ№ пјҢ еҸӘиҝӣиЎҢзү№еҫҒзҡ„еҲҶеҸ‘дёҚиҝӣиЎҢи®Ўз®—пјӣжңҖеҗҺдёҖдёӘиҠӮзӮ№иў«жҢҮе®ҡдёәиҫ“еҮәиҠӮзӮ№ пјҢ еҸӘд»ҺеүҚеәҸиҠӮзӮ№иҺ·еҸ–иҫ“е…Ҙ并иҝӣиЎҢиһҚеҗҲдҪңдёәеӣҫзҡ„иҫ“еҮәзү№еҫҒ гҖӮ жҲ‘们жҸҗеҮәдҪҝз”ЁйӮ»жҺҘзҹ©йҳөжқҘеӯҳеӮЁиҫ№зҡ„жқғйҮҚ пјҢ еҰӮеӣҫ2еҸідҫ§жүҖзӨә пјҢ зҹ©йҳөзҡ„иЎҢиЎЁзӨәиҫ“е…Ҙиҫ№зҡ„жқғйҮҚ пјҢ еҲ—иЎЁзӨәиҫ“еҮәиҫ№зҡ„жқғйҮҚ гҖӮ

жҺЁиҚҗйҳ…иҜ»

- з©ҝжҗӯ|2020з§ӢеӯЈеҮәй—Ёиҝҷж ·з©ҝиҘҝиЈ…пјҢдҪ е°ұжҳҜиЎ—дёҠжңҖдә®зҡ„д»”

- еҹәе°”ж‘©ж–Ҝ|2020е№ҙдёӯжҠҘжңҖжңүж–ҷзҡ„з“ңпјҢдёҖж–ҮзңӢе°Ҫ

- 2020е№ҙеә•|еҠ з ҒйқһжІ№дёҡеҠЎдёӯзҹіеҢ–ејҖи·Ёеўғй—Әиҙӯеә—

- еңЁејҖж”ҫеҗҲдҪңдёӯе…ұиөўвҖ”вҖ”и·ЁеӣҪе…¬еҸёзңӢ2020е№ҙжңҚиҙёдјҡ

- ж–ҮжұҮжҠҘ|AIвҖңзҘһеҷЁвҖқдёҠеІ—ж— дәәиҪҰжҗ¬иЎҢжқҺпјҢеҗҢжөҺеӨ§еӯҰиҝҺ2020зә§жң¬з§‘ж–°з”ҹ

- 科жҠҖж—ҘжҠҘ|2020жңҚиҙёдјҡпјҡдёҖеңәи¶…д№ҺжғіиұЎзҡ„科жҠҖзӣӣжҷҜ

- 2020е№ҙ|еҫ·ж–№зәізұіпјҡжқҫзҰҫеҲӣжҠ•и§ЈйҷӨиҙЁжҠј331дёҮиӮЎ

- еӨ§жІіе®ўжҲ·з«Ҝ|еёғеұҖжҲҳйҳҹпјҢеҜјеёҲеҗ„жңүеҰҷжӢӣпјҢгҖҠ2020дёӯеӣҪеҘҪеЈ°йҹігҖӢ收и§ҶзҺҮиқүиҒ”第дёҖ

- е°Ғйқўж–°й—»|7е№ҙжҠ•е…Ҙиҝ‘7000дёҮ йј“еҠұ8253дәә йҳҝйҮҢе·ҙе·ҙеҸ‘еёғ2020е№ҙеәҰжӯЈиғҪйҮҸжҠҘе‘Ҡ

- еӨ®и§Ҷж–°й—»|иҜ•еҚ·иҮӘеҠЁжү№ж”№гҖҒж ҮжіЁвҖҰвҖҰеңЁзәҝж•ҷиӮІдјҒдёҡжҲҗ2020жңҚиҙёдјҡж•ҷиӮІжңҚеҠЎеұ•дё»еҠӣеҶӣ

![[]银иЎҢе‘ҳе·Ҙпјҡеӯҳж¬ҫиҫҫеҲ°вҖңиҝҷдёӘж•°вҖқпјҢжҜҸжңҲеҲ©жҒҜзӣёеҪ“дәҺеҫҲеӨҡдәә2дёӘжңҲе·Ҙиө„](http://img88.010lm.com/img.php?https://image.uc.cn/s/wemedia/s/upload/2020/853d39c4ad136e01fcfb3249ceeb873d.jpg)

![[зҶҠеӯ©еӯҗд№җеӣӯ]д»ҺжқҘдёҚеҒҡиҝҷдёү件дәӢпјҢдәәзјҳи¶ҠжқҘи¶ҠеҘҪпјҢдәәйҷ…дәӨеҫҖ规еҲҷпјҡжғ…е•Ҷй«ҳзҡ„дәә](https://imgcdn.toutiaoyule.com/20200330/20200330145713047207a_t.jpeg)