BERT|еёёиҜҶзҹҘиҜҶзЎ®иғҪиў«жҚ•иҺ·пјҢиҘҝж№–еӨ§еӯҰеҚҡеЈ«жҺўз©¶BERTеҰӮдҪ•еҒҡеёёиҜҶй—®зӯ”( дәҢ )

BERT жҳҜеҗҰеҢ…еҗ«з»“жһ„еҢ–еёёиҜҶзҹҘиҜҶпјҹ

з ”з©¶иҖ…йҰ–е…ҲиҝӣиЎҢдәҶдёҖз»„е®һйӘҢжқҘжҺўз©¶еёёиҜҶй“ҫжҺҘжқғйҮҚпјҢд»ҺиҖҢеҸҜд»ҘеҸҚжҳ еҮәеёёиҜҶзҹҘиҜҶжҳҜеҗҰдјҡиў«еҸҘеӯҗзҡ„ BERT иЎЁзӨәжҚ•иҺ·гҖӮ

зӣҙи§Ӯең°и®ІпјҢеҰӮжһңзӯ”жЎҲжҰӮеҝөеҲ°й—®йўҳжҰӮеҝөзҡ„й“ҫжҺҘжқғйҮҚй«ҳдәҺзӯ”жЎҲжҰӮеҝөеҲ°е…¶д»–з–‘й—®иҜҚзҡ„й“ҫжҺҘжқғйҮҚпјҢеҲҷ ConceptNet дёӯзҡ„еёёиҜҶзҹҘиҜҶжҳҜйҖҡиҝҮз»ҸйӘҢиЎЁзӨәжҚ•иҺ·зҡ„гҖӮ

еҖјеҫ—жіЁж„Ҹзҡ„жҳҜпјҢ[CLS] token зҡ„иЎЁзӨәдёҚжҳҜй—®йўҳжҰӮеҝөпјҢиҖҢжҳҜзӣҙжҺҘиҝһжҺҘиҮіиҫ“еҮәеұӮд»ҘиҝӣиЎҢеҖҷйҖүиҜ„еҲҶгҖӮеӣ жӯӨпјҢеңЁйў„и®ӯз»ғе’Ңеҫ®и°ғйҳ¶ж®өпјҢеҜ№дәҺиҫ“еҮәеұӮд»ҘеҸҠзӯ”жЎҲжҰӮеҝө token еҲ°й—®йўҳжҰӮеҝө token зҡ„й“ҫжҺҘжқғйҮҚпјҢйғҪжІЎжңүзӣҙжҺҘзҡ„зӣ‘зқЈдҝЎеҸ·гҖӮ

жҺўжөӢд»»еҠЎпјҲprobing taskпјү

з ”з©¶иҖ…йҖҡиҝҮи®Ўз®—жңҖзӣёе…ізҡ„иҜҚпјҲmost associated word, MAWпјүжқҘиҜ„дј°й“ҫжҺҘжқғйҮҚпјҢе…¶дёӯ MAW жҳҜд»ҺжүҖжңүз–‘й—®иҜҚдёӯзҡ„зӯ”жЎҲжҰӮеҝөдёӯиҺ·еҫ—жңҖеӨ§й“ҫжҺҘжқғйҮҚзҡ„й—®йўҳжҰӮеҝөиҜҚгҖӮз ”з©¶иҖ…и®Ўз®—дәҶжҜҸеұӮдёӯжҜҸдёӘжіЁж„ҸеҠӣеӨҙзҡ„ MAWгҖӮ

гҖҗ BERT|еёёиҜҶзҹҘиҜҶзЎ®иғҪиў«жҚ•иҺ·пјҢиҘҝж№–еӨ§еӯҰеҚҡеЈ«жҺўз©¶BERTеҰӮдҪ•еҒҡеёёиҜҶй—®зӯ”гҖ‘е®һйӘҢз»“жһң

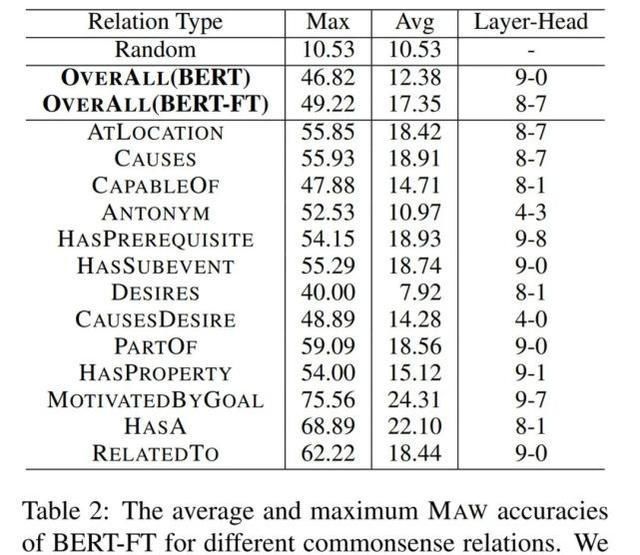

дёӢиЎЁ 2 еұ•зӨәдәҶеҜ№дәҺдёҚеҗҢзҡ„еёёиҜҶе…ізі»пјҢеҺҹе§ӢеҪ’дёҖеҢ– BERT е’ҢеңЁ CommonsenseQA дёҠеҫ®и°ғзҡ„ BERT жЁЎеһӢзҡ„е№іеқҮе’ҢжңҖеӨ§еҮҶзЎ®зҺҮз»“жһңпјҡ

ж–Үз« еӣҫзүҮ

йҰ–е…Ҳи§ӮеҜҹжңӘз»Ҹеҫ®и°ғзҡ„еҺҹе§Ӣ BERTпјҢжҜҸдёҖеұӮзҡ„жңҖеӨ§ MAW еҮҶзЎ®зҺҮжҳҺжҳҫдјҳдәҺйҡҸжңәеҹәеҮҶгҖӮиҝҷиЎЁжҳҺ BERT зЎ®е®һжҚ•иҺ·дәҶеёёиҜҶзҹҘиҜҶгҖӮжӯӨеӨ–пјҢBERT зҡ„е№іеқҮ MAW д№ҹжҳҺжҳҫдјҳдәҺйҡҸжңәеҹәеҮҶпјҲp еҖј < 0.01пјүпјҢиҝҷиЎЁжҳҺзӣёе…ізҡ„й—®йўҳжҰӮеҝөж— йңҖеҫ®и°ғеҚіеҸҜеңЁ BERT зј–з ҒдёӯеҸ‘жҢҘйқһеёёйҮҚиҰҒзҡ„дҪңз”ЁгҖӮ

е…¶ж¬ЎпјҢе°ұе№іеқҮ MAW еҮҶзЎ®зҺҮе’ҢжңҖеӨ§ MAW еҮҶзЎ®зҺҮиҖҢиЁҖпјҢBERT-FT еқҮдјҳдәҺ BERTгҖӮиҝҷиЎЁжҳҺеҜ№еёёиҜҶд»»еҠЎзҡ„зӣ‘зқЈи®ӯз»ғеҸҜд»Ҙеўһејәз»“жһ„еҢ–зҡ„еёёиҜҶзҹҘиҜҶгҖӮ

BERT еҰӮдҪ•е°ҶеёёиҜҶзҹҘиҜҶз”ЁдәҺеёёиҜҶд»»еҠЎпјҹ

з ”з©¶иҖ…иҝӣдёҖжӯҘиҝӣиЎҢдәҶдёҖз»„е®һйӘҢпјҢжқҘжҸҸиҝ°еёёиҜҶй“ҫжҺҘдёҺжЁЎеһӢйў„жөӢд№Ӣй—ҙзҡ„зӣёе…іжҖ§гҖӮзӣ®зҡ„жҳҜдёәдәҶз ”з©¶дёҚеҗҢеҖҷйҖүзӯ”жЎҲжҰӮеҝөеҲ°й—®йўҳжҰӮеҝөзҡ„й“ҫжҺҘжқғйҮҚжҳҜеҗҰдјҡеҜ№иҝҷдәӣеҖҷйҖүзӯ”жЎҲд№Ӣй—ҙзҡ„жЁЎеһӢеҶізӯ–йҖ жҲҗеҪұе“ҚгҖӮ

е…·дҪ“иҖҢиЁҖпјҢз ”з©¶иҖ…жҜ”иҫғдәҶ 5 дёӘеҖҷйҖүзӯ”жЎҲеҜ№дәҺеҗҢдёҖй—®йўҳзҡ„й“ҫжҺҘжқғйҮҚпјҢ并жүҫеҮәдәҶдёҺзӣёе…ій—®йўҳжҰӮеҝөжңҖзӣёе…ізҡ„еҖҷйҖүзӯ”жЎҲгҖӮиҝҷдёӘеҖҷйҖүзӯ”жЎҲиў«з§°дёәжңҖзӣёе…іеҖҷйҖүеҜ№иұЎпјҲmost associated candidate, MACпјүгҖӮMAC е’ҢжҜҸдёӘй—®йўҳзҡ„жЁЎеһӢйў„жөӢд№Ӣй—ҙд№ҹеӯҳеңЁзқҖзӣёе…іжҖ§гҖӮзӣҙи§Ӯең°и®ІпјҢеҰӮжһң MAC дёҺжЁЎеһӢйў„жөӢе‘ҲзҺ°зӣёе…іжҖ§пјҢеҲҷиҜҒжҳҺжЁЎеһӢеңЁйў„жөӢиҝҮзЁӢдёӯиҝҗз”ЁеҲ°дәҶеёёиҜҶзҹҘиҜҶгҖӮ

з ”з©¶иҖ…иҝӣиЎҢе®һйӘҢжқҘиҜ„дј° MAC еҜ№жЁЎеһӢеҶізӯ–зҡ„иҙЎзҢ®пјҢд»ҘеҸҠ MAC дҫқиө–дёҺиҫ“еҮәеҮҶзЎ®зҺҮд№Ӣй—ҙзҡ„зӣёе…іжҖ§гҖӮе®һйӘҢдёӯдҪҝз”ЁжіЁж„ҸеҠӣжқғйҮҚе’ҢеҪ’еӣ еҫ—еҲҶжқҘжөӢйҮҸй“ҫжҺҘпјҢиҝҷжҳҜеӣ дёәеңЁиҖғиҷ‘жЁЎеһӢйў„жөӢж—¶жўҜеәҰдјҡеҸ‘жҢҘдҪңз”ЁгҖӮ

жӯӨеӨ–пјҢеҜ№дәҺжүҖжңүиҜ•йӘҢжқҘиҜҙпјҢеҪ’еӣ еҫ—еҲҶзҡ„и¶ӢеҠҝдёҺдҪҝз”ЁжіЁж„ҸеҠӣжқғйҮҚжөӢйҮҸзҡ„з»“жһңдҝқжҢҒдёҖиҮҙгҖӮ

жҺўжөӢд»»еҠЎ

д»ҺеҪўејҸдёҠпјҢз»ҷе®ҡдёҖдёӘй—®йўҳ q е’Ң 5 дёӘеҖҷйҖүзӯ”жЎҲ a1, ..., a5пјҢз ”з©¶иҖ…еҜ№зӣёеә”зҡ„ 5 дёӘеҖҷйҖүеҸҘеӯҗ s1, ..., s5 иҝӣиЎҢжҜ”иҫғгҖӮеңЁжҜҸдёӘеҖҷйҖүеҸҘеӯҗдёӯпјҢз ”з©¶иҖ…ж №жҚ® ConceptNet и®Ўз®—дәҶзӯ”жЎҲжҰӮеҝөеҲ°й—®йўҳжҰӮеҝөзҡ„й“ҫжҺҘжқғйҮҚгҖӮ

з ”з©¶иҖ…йҖҡиҝҮжөӢйҮҸзӯ”жЎҲжҰӮеҝөеҲ° [CLS]token зҡ„й“ҫжҺҘжқғйҮҚпјҢиҝӣдёҖжӯҘе®ҡд№үдәҶжңҖзӣёе…іеҸҘеӯҗпјҲmost associated sentence, MASпјүгҖӮиҝҷжҳҜеӣ дёәжўҜеәҰжҳҜд»Һ [CLS]token еҗҺеҗ‘дј ж’ӯпјҢиҖҢдёҚжҳҜд»Һй—®йўҳжҰӮеҝөжҲ–зӯ”жЎҲжҰӮеҝөгҖӮ

жӯӨеӨ–пјҢйҖҡиҝҮжҜ”иҫғ MAC е’Ң MASпјҢз ”з©¶иҖ…еҸҜд»ҘиҺ·еҫ— MAC жҳҜеҗҰеҜ№жЁЎеһӢеҶізӯ–йҖ жҲҗеҪұе“Қзҡ„жңүз”ЁдҝЎжҒҜгҖӮ

еёёиҜҶй“ҫжҺҘзҡ„йҮҚиҰҒжҖ§

з ”з©¶иҖ…жөӢйҮҸдәҶ BERT-FT е’Ң BERT-ProbingпјҲиҝҷжҳҜдёҖдёӘд»…й’ҲеҜ№иҫ“еҮәеұӮиҝӣиЎҢеҫ®и°ғзҡ„ BERT еҸҳдҪ“пјүзҡ„ MAC жҖ§иғҪпјҢе…¶дёӯ BERT-Probing жҳҜдёҖдёӘзәҝжҖ§жҺўжөӢпјҲlinear probingпјүжЁЎеһӢгҖӮзӣҙи§Ӯең°и®ІпјҢеҰӮжһңзәҝжҖ§еҲҶзұ»еҷЁеҸҜд»Ҙйў„жөӢеёёиҜҶд»»еҠЎпјҢеҲҷжңӘз»Ҹеҫ®и°ғзҡ„еҺҹе§ӢжЁЎеһӢеҸҜиғҪдјҡзј–з Ғдё°еҜҢзҡ„еёёиҜҶзҹҘиҜҶгҖӮ

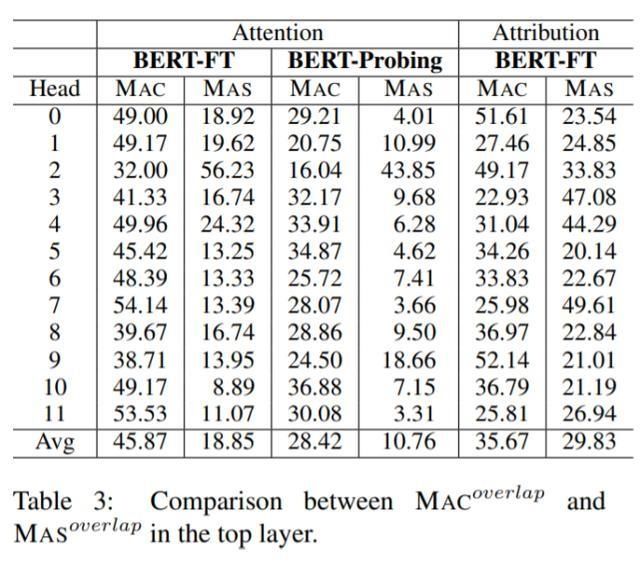

дёӢиЎЁ 3 дёә top Transformer еұӮдёӯ 12 дёӘжіЁж„ҸеҠӣеӨҙжқЎд»¶дёӢпјҢMAC е’Ң MAS зҡ„йҮҚеҸ зҺҮпјҲoverlapping rateпјүпјҡ

ж–Үз« еӣҫзүҮ

еёёиҜҶй“ҫжҺҘдёҺжЁЎеһӢйў„жөӢд№Ӣй—ҙзҡ„зӣёе…іжҖ§

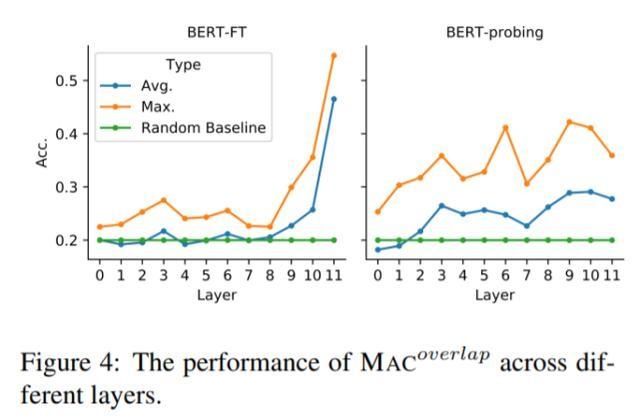

дёәдәҶиҝӣдёҖжӯҘжҺўз©¶еёёиҜҶзҹҘиҜҶеҜ№жЁЎеһӢйў„жөӢзҡ„иҙЎзҢ®пјҢдёӢеӣҫ 4 еұ•зӨәдәҶжҜҸдёӘ Transformer еұӮдёҠ MAC е’ҢжЁЎеһӢйў„жөӢд№Ӣй—ҙзҡ„йҮҚеҸ зҺҮпјҡ

ж–Үз« еӣҫзүҮ

дёӢиЎЁ 4 еҲҷеұ•зӨәдәҶ MAC еҮҶзЎ®зҺҮе’Ңйў„жөӢеҮҶзЎ®зҺҮд№Ӣй—ҙзҡ„зӣёе…іжҖ§пјҡ

ж–Үз« еӣҫзүҮ

дёҚеҗҢеұӮзҡ„иҙЎзҢ®

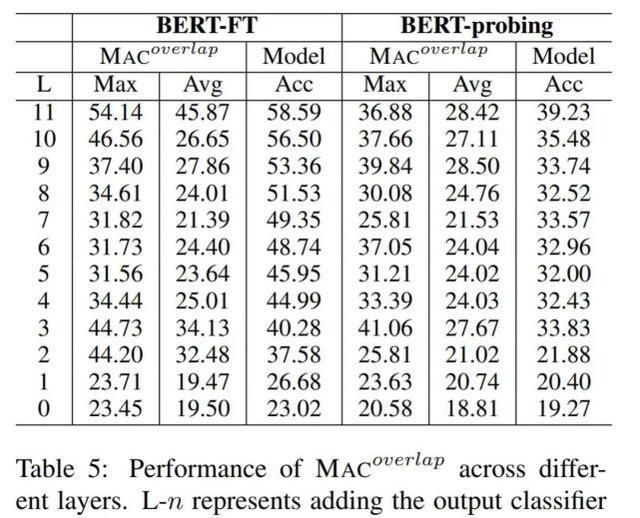

жңҖеҗҺпјҢз ”з©¶иҖ…иҝӣдёҖжӯҘжҺўз©¶дәҶеёёиҜҶзҹҘиҜҶдҪҝз”ЁдёҠзҡ„дёӨдёӘе…·дҪ“й—®йўҳгҖӮе…¶дёҖпјҢеңЁеҶізӯ–иҝҮзЁӢдёӯпјҢBERT жңҖдҫқиө–е“ӘдёӘеұӮпјҹе…¶дәҢпјҢBERT дҪҝз”Ёзҡ„еёёиҜҶзҹҘиҜҶжқҘиҮӘйў„и®ӯз»ғжҲ–еҫ®и°ғеҗ—пјҹдёәжӯӨпјҢз ”з©¶иҖ…йҖҡиҝҮиҝһжҺҘжҜҸдёӘ Transformer еұӮдёҠзҡ„иҫ“еҮәеұӮпјҢеҜ№ 12 дёӘжЁЎеһӢеҸҳдҪ“иҝӣиЎҢдәҶжҜ”иҫғгҖӮ

дёӢиЎЁ 5 еұ•зӨәдәҶжЁЎеһӢеҮҶзЎ®зҺҮе’Ң MAC йҮҚеҸ зҺҮзҡ„ж•°жҚ®пјҡ

ж–Үз« еӣҫзүҮ

гҖҗжқҘжәҗпјҡиҫҫиҫҫж•ҷиӮІгҖ‘

еЈ°жҳҺпјҡиҪ¬иҪҪжӯӨж–ҮжҳҜеҮәдәҺдј йҖ’жӣҙеӨҡдҝЎжҒҜд№Ӣзӣ®зҡ„гҖӮиӢҘжңүжқҘжәҗж ҮжіЁй”ҷиҜҜжҲ–дҫөзҠҜдәҶжӮЁзҡ„еҗҲжі•жқғзӣҠпјҢиҜ·дҪңиҖ…жҢҒжқғеұһиҜҒжҳҺдёҺжң¬зҪ‘иҒ”зі»пјҢжҲ‘们е°ҶеҸҠж—¶жӣҙжӯЈгҖҒеҲ йҷӨпјҢи°ўи°ўгҖӮ йӮ®з®ұең°еқҖпјҡnewmedia@xxcb.cn

жҺЁиҚҗйҳ…иҜ»

- жҖҘж•‘|жҖҘж•‘ж•ҷиӮІдёҚиғҪе…үи®ІзҹҘиҜҶ иҝҳиҰҒеҹ№е…»зҺ°еңәеә”еҜ№иғҪеҠӣ

- еӯҰе…Ёиҝҗ|еӯҰе…ЁиҝҗзҹҘиҜҶ еұ•еӯҰз”ҹйЈҺйҮҮ

- зҘһз»Ҹе…ғз»Ҷиғһ|иҝҷзҹҘиҜҶе®ғдёҚиҝӣи„‘еӯҗе‘ҖвҖ”вҖ”и®°еҝҶйғҪеҺ»е“Әе„ҝдәҶпјҹ

- зҹҘиҜҶ科жҷ®|дҪ еңЁиӢұеӣҪиҜ»зҡ„еӨ§еӯҰзӣёеҪ“дәҺеӣҪеҶ…е“ӘжүҖеӨ§еӯҰпјҹжңҖж–°QSжҺ’еҗҚеҜ№жҜ”пјҒ

- зҹҘиҜҶ科жҷ®|MBAеҸҜд»ҘдёәдҪ еҒҡд»Җд№Ҳ

- зҹҘиҜҶ科жҷ®|дёӘдәәеҰӮдҪ•иҝҗиҗҘеҝ«йҖ’жҹңпјҹ

- еҚ«з”ҹйҳІз–«жңәжһ„|еёҢи…Ҡеҗ‘з§»ж°‘е®Јдј йҳІз–«зҹҘиҜҶ еӨҡз§ҚиҜӯиЁҖж’ӯжҠҘжҠ—з–«дҝЎжҒҜ

- зҹҘиҜҶ科жҷ®|жңҖж–°2020е№ҙејҖи®ҫжңҚиЈ…иЎЁжј”жЁЎзү№дё“дёҡзҡ„жң¬з§‘йҷўж Ўжңүе“Әдәӣ

- зҹҘиҜҶ科жҷ®|й«ҳйӣҶжҲҗ|иөӣе°”еҖҫж–ңзӣёжңәеҚҮзә§д№Ӣи·ҜвҖ”вҖ”жӣҙе°Ҹ.жӣҙиҪ».жӣҙзІҫ

- иҜҲйӘ—|еҮҖзҪ‘2020 ејҖеӯҰдәҶпјҒиҝҷдәӣвҖңйҳІиҜҲйӘ—вҖқзҹҘиҜҶд№ҹдёҚиғҪиҗҪдёӢ