пјҲIпјүиҙҹиҪҪеқҮиЎЎеҷЁпјҡдёәжҜҸдёӘжЁЎеһӢжҺЁзҗҶеңЁзәҝжңҚеҠЎжҸҗдҫӣиҮӘеҠЁиҙҹиҪҪеқҮиЎЎиғҪеҠӣ пјҢ еҚіе°ҶпјҲHпјүеҺӢеҠӣжөӢиҜ•/еңЁзәҝжңҚеҠЎдёӯдә§з”ҹеӨ§и§„жЁЎиҜ·жұӮжөҒйҮҸйҖҡиҝҮиҙҹиҪҪеқҮиЎЎз®—жі•е°ҶиҜ·жұӮеҲҶй…ҚеҲ°еҗ„дёӘи®Ўз®—иҠӮзӮ№зҡ„е®№еҷЁе®һдҫӢдёӯ гҖӮиҙҹиҪҪеқҮиЎЎз®—жі•йҮҮз”ЁйҡҸжңәжі•гҖҒиҪ®иҜўжі•гҖҒеҺҹең°еқҖе“ҲеёҢжі•гҖҒеҠ жқғиҪ®иҜўжі•гҖҒжңҖе°ҸиҝһжҺҘж•°жі•зӯү гҖӮ

пјҲJпјүзі»з»ҹ/жңҚеҠЎзҠ¶жҖҒзӣ‘жҺ§жЁЎеқ—пјҡеҜ№жҜҸдёӘжЁЎеһӢжңҚеҠЎжҺЁзҗҶзҡ„еҮҶзЎ®жҖ§жҢҮж Ү(еҰӮйқўеҗ‘еҲҶзұ»жЁЎеһӢзҡ„зІҫзЎ®зҺҮгҖҒеҸ¬еӣһзҺҮгҖҒF1еҖјгҖҒAUCзӯүе’Ңйқўеҗ‘еӣһеҪ’жЁЎеһӢзҡ„MSEгҖҒRMSEгҖҒMAEзӯү)гҖҒжЁЎеһӢжҺЁзҗҶжңҚеҠЎзҡ„дҪҝз”Ёжғ…еҶөд»ҘеҸҠиө„жәҗзҡ„дҪҝз”ЁзҠ¶жҖҒиҝӣиЎҢе…Ёж–№дҪҚзҡ„йҮҮйӣҶгҖҒеӯҳеӮЁ пјҢ 并иҝӣиЎҢдёҚеҗҢж—¶й—ҙзІ’еәҰзҡ„жұҮжҖ»и®Ўз®— пјҢ дё»иҰҒзҡ„зӣ‘жҺ§жҢҮж ҮеҢ…жӢ¬CPUдҪҝз”ЁзҺҮгҖҒGPUдҪҝз”ЁзҺҮгҖҒеҶ…еӯҳдҪҝз”ЁзҺҮгҖҒеҚ з”ЁеӯҳеӮЁз©әй—ҙгҖҒдёҠдёӢиЎҢжөҒйҮҸгҖҒжңҚеҠЎиҜ·жұӮж•°йҮҸгҖҒжңҚеҠЎи°ғз”ЁеӨұиҙҘ/жҲҗеҠҹж•°йҮҸгҖҒжңҚеҠЎе“Қеә”时延зӯү пјҢ 并计算еҸҚеә”жЁЎеһӢжңҚеҠЎжҖ§иғҪзЁіе®ҡжҖ§е’ҢеҸҜйқ жҖ§зҡ„иЎҚз”ҹжҢҮж Ү пјҢ еҰӮTP99гҖҒTP9999зӯү гҖӮиҜҘйғЁеҲҶдҝЎжҒҜдёҖж–№йқўжҳҜпјҲKпјүзӣ‘жҺ§йқўжқҝдёҠиҝӣиЎҢеҸҜи§ҶеҢ–зҡ„еҹәзЎҖ пјҢ еҸҰдёҖж–№йқўд№ҹдјҡеҸҚйҰҲз»ҷпјҲEпјүKubernetesйӣҶзҫӨ пјҢ з”ЁдәҺжҢҮеҜјиө„жәҗзҡ„еҲҶй…Қи°ғеәҰе’ҢжңҚеҠЎзҡ„зј–жҺ’ гҖӮ

пјҲKпјүзӣ‘жҺ§йқўжқҝпјҡе°ҶпјҲJпјүзі»з»ҹ/жңҚеҠЎзҠ¶жҖҒзӣ‘жҺ§жЁЎеқ—дёӯйҮҮйӣҶгҖҒи®Ўз®—зҡ„жҢҮж ҮиҝӣиЎҢеҸҜи§ҶеҢ– пјҢ ж–№дҫҝз”ЁжҲ·дәҶи§ЈжЁЎеһӢеңЁзәҝжҺЁзҗҶжңҚеҠЎзҡ„зҠ¶жҖҒ гҖӮ

3. жЁЎеһӢиҮӘеҠЁзӯӣйҖүдёҺжӣҙж–°жөҒзЁӢ

жңәеҷЁеӯҰд№ жЁЎеһӢеҫҖеҫҖдјҡйҡҸзқҖж—¶й—ҙзҡ„жҺЁз§»иҝӣиЎҢиҝӯд»Јжӣҙж–° пјҢ дёәдҝқйҡңжЁЎеһӢеңЁзәҝжҺЁзҗҶжңҚеҠЎзҡ„еҮҶзЎ®жҖ§ пјҢ йңҖеҜ№е…¶иҝӣиЎҢеҚіж—¶зҡ„еҚҮзә§ гҖӮжң¬ж–ҮжҸҗеҮәдёҖз§ҚжЁЎеһӢиҮӘеҠЁеҢ–зҡ„жЁЎеһӢзӯӣйҖүж–№жі•е’Ңзӯ–з•Ҙ пјҢ д»ҘеҮҸе°‘дәәе·Ҙж“ҚдҪң гҖӮе…·дҪ“жөҒзЁӢеҰӮеӣҫ2жүҖзӨә гҖӮ

ж–Үз« жҸ’еӣҫ

еӣҫ2 жЁЎеһӢиҮӘеҠЁзӯӣйҖүгҖҒжӣҙж–°жөҒзЁӢзӨәж„Ҹеӣҫ

з”ЁжҲ·ж №жҚ®зі»з»ҹжҸҗдҫӣзҡ„еӨҡз§ҚзӯӣйҖүзӯ–з•ҘжЁЎжқҝ пјҢ иҝӣиЎҢзӯ–з•Ҙй…ҚзҪ®д»ҘеҲқе§ӢеҢ–жЁЎеһӢзӯӣйҖүеҷЁ пјҢ жЁЎеһӢзӯӣйҖүеҷЁеҜ№пјҲBпјүжЁЎеһӢд»“еә“дёӯзҡ„жҜҸдёӘжЁЎеһӢеҸҠе…¶дёҚеҗҢзүҲжң¬зҡ„е…ғдҝЎжҒҜиҝӣиЎҢжЈҖжөӢ пјҢ зӯӣйҖүеҮәз¬ҰеҗҲзӯ–з•ҘжүҖе®ҡд№үиҰҒжұӮзҡ„жЁЎеһӢж–Ү件 пјҢ 然еҗҺз”ұпјҲDпјүжЁЎеһӢеҫ®жңҚеҠЎеј•ж“ҺеҜ№жЁЎеһӢеңЁзәҝжҺЁзҗҶжңҚеҠЎеңЁеҗҲйҖӮзҡ„ж—¶ж®ө(еҰӮпјҲJпјүзі»з»ҹ/жңҚеҠЎзҠ¶жҖҒзӣ‘жҺ§жЁЎеқ—зӣ‘жөӢеҲ°зҡ„жңҚеҠЎи°ғз”ЁйҮҸиҫғдҪҺзҡ„ж—¶ж®өжҲ–з”ЁжҲ·иҮӘе®ҡд№үзҡ„ж—¶ж®ө)иҝӣиЎҢжӣҙж–° гҖӮ

е…·дҪ“ең° пјҢ жң¬ж–ҮжҸҗеҮәд»ҘдёӢ5з§ҚжЁЎеһӢзӯӣйҖүзӯ–з•ҘжЁЎжқҝпјҡ

в‘ з”ұдёҠжёёж•°жҚ®й©ұеҠЁзҡ„жЁЎеһӢжӣҙж–° пјҢ еҚізӯӣйҖүеҮәиҜҘй©ұеҠЁдәӢ件еҜ№еә”зҡ„жЁЎеһӢпјӣ

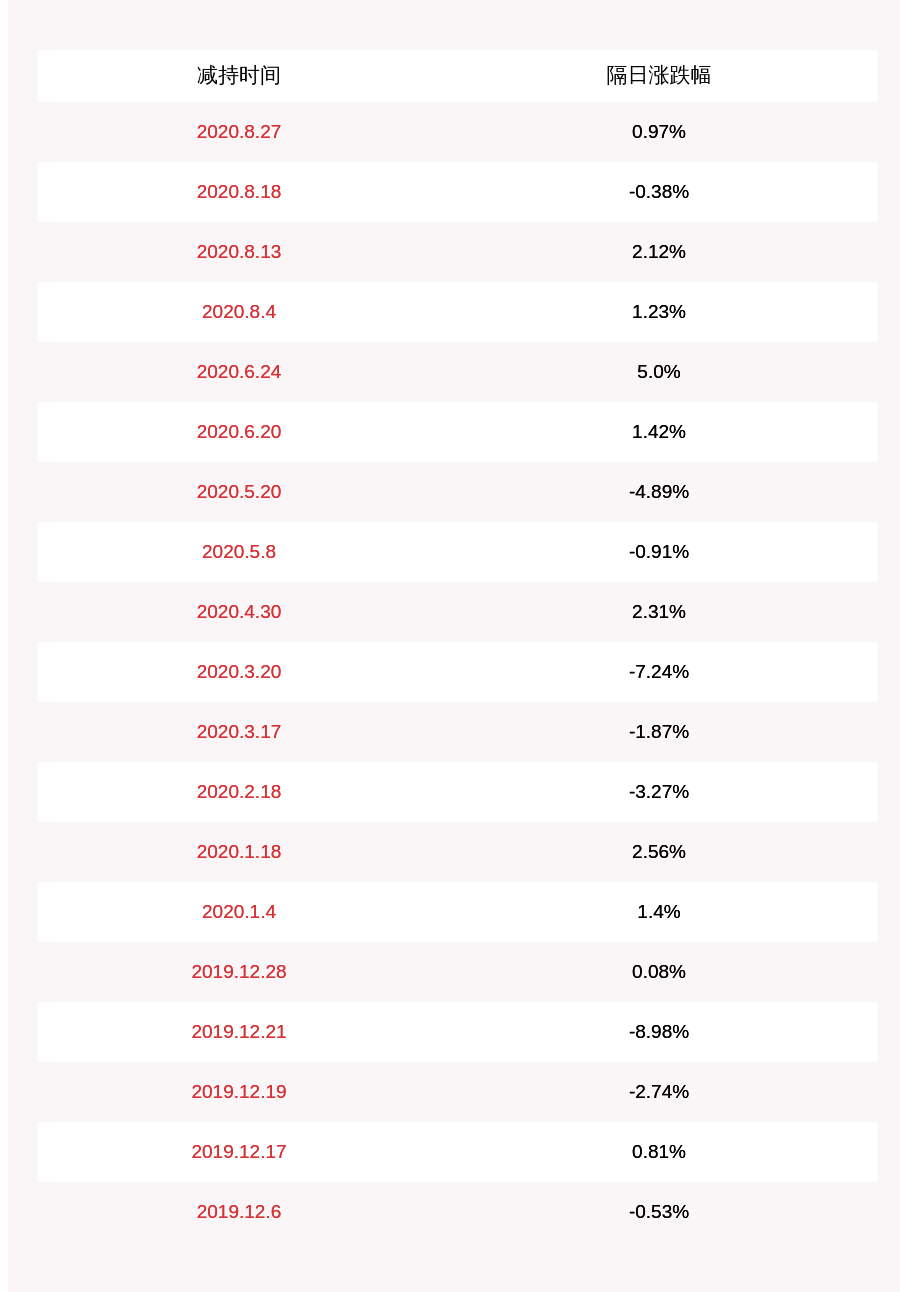

в‘Ў жЁЎеһӢжҺЁзҗҶеҮҶзЎ®жҖ§жҢҮж ҮдёӢйҷҚжҲ–дҪҺдәҺдёҖе®ҡйҳҲеҖјдәӢ件й©ұеҠЁзҡ„жЁЎеһӢжӣҙж–° пјҢ еҚізӯӣйҖүеҮәиҜҘй©ұеҠЁдәӢ件еҜ№еә”зҡ„жЁЎеһӢ пјҢ жЁЎеһӢжҺЁзҗҶеҮҶзЎ®жҖ§жҢҮж Үз”ұпјҲJпјүзі»з»ҹ/жңҚеҠЎзҠ¶жҖҒзӣ‘жҺ§жЁЎеқ—зӣ‘жөӢжЁЎеқ—еҸҚйҰҲ пјҢ и§Ғеӣҫ1пјӣ

в‘ў е®ҡжңҹд»ҺеҪ“еүҚдј—еӨҡзүҲжң¬дёӯзӯӣйҖүеҮәжЁЎеһӢжҖ§иғҪиҜ„дј°жҢҮж Ү(еҸҜд»ҘжҳҜз”ЁжҲ·е®ҡд№үзҡ„еҠ жқғжҢҮж Ү пјҢ дёӢеҗҢ)жңҖдјҳзҡ„дёҖдёӘжЁЎеһӢпјӣ

в‘Ј е®ҡжңҹд»ҺеҪ“еүҚдј—еӨҡзүҲжң¬дёӯзӯӣйҖүеҮәжЁЎеһӢжҖ§иғҪиҜ„дј°жҢҮж ҮеңЁдёҖе®ҡйҳҲеҖјд№ӢдёҠзҡ„жңҖж–°иҝӯд»Јзҡ„дёҖдёӘжЁЎеһӢпјӣ

в‘Ө дәәе·ҘжүӢеҠЁжҢҮе®ҡзҡ„жЁЎеһӢзүҲжң¬ гҖӮ

4. иө„жәҗеј№жҖ§жү©зј©е®№ж–№жі•

еӨ§еӨҡж•°жЁЎеһӢеңЁзәҝжҺЁзҗҶжңҚеҠЎзҡ„и°ғз”ЁйҮҸеҫҖеҫҖдјҡйҡҸзқҖдёҡеҠЎзҡ„ж¶ЁиҗҪиҖҢж¶ЁиҗҪ пјҢ з»ҸеёёеҮәзҺ°зұ»дјјзҷҪеӨ©й«ҳгҖҒеӨңй—ҙдҪҺзҡ„жңҚеҠЎиҜ·жұӮйҮҸжіўеҠЁзҺ°иұЎ пјҢ дёҖж–№йқўеҜјиҮҙ硬件иө„жәҗеңЁи°ғз”ЁйҮҸиҫғдҪҺжңҹй—ҙдҪҝз”ЁзҺҮдҪҺ пјҢ йҖ жҲҗиө„жәҗжөӘиҙ№ пјҢ еҸҰдёҖж–№йқўеҪ“з”ЁйҮҸиҝҮеӨ§ж—¶еҸҜиғҪеҪұе“ҚжңҚеҠЎзҡ„зЁіе®ҡжҖ§е’ҢеҸҜз”ЁжҖ§ гҖӮжң¬ж–ҮжҸҗеҮәдёҖз§ҚжЁЎеһӢжңҚеҠЎиө„жәҗзҡ„еј№жҖ§жү©зј©е®№ж–№жі• пјҢ ж—ўдҝқиҜҒжЁЎеһӢжҺЁзҗҶжңҚеҠЎзҡ„иө„жәҗйңҖжұӮ пјҢ еҸҲеҮҸе°‘иө„жәҗзҡ„й—ІзҪ®жөӘиҙ№ гҖӮе…·дҪ“жөҒзЁӢеҰӮеӣҫ3жүҖзӨә гҖӮ

ж–Үз« жҸ’еӣҫ

еӣҫ3 жЁЎеһӢжңҚеҠЎиө„жәҗеј№жҖ§жү©зј©е®№жөҒзЁӢзӨәж„Ҹеӣҫ

еҪ“жЁЎеһӢеңЁзәҝжҺЁзҗҶжңҚеҠЎжҲҗеҠҹйғЁзҪІдёҠзәҝеҗҺ пјҢ пјҲJпјүзі»з»ҹ/жңҚеҠЎзҠ¶жҖҒзӣ‘жҺ§жЁЎеқ—е®һж—¶зӣ‘жөӢгҖҒи®Ўз®—иҜҘжңҚеҠЎеҗ„е®№еҷЁе®һдҫӢзҡ„иө„жәҗдҪҝз”ЁзҺҮзӯүжҢҮж Ү пјҢ еҰӮCPUдҪҝз”ЁзҺҮгҖҒGPUдҪҝз”ЁзҺҮгҖҒеҶ…еӯҳдҪҝз”ЁзҺҮгҖҒе“Қеә”时延зӯү пјҢ 并иҝӣиЎҢдёҚеҗҢж—¶й—ҙзІ’еәҰзҡ„жұҮжҖ»и®Ўз®— гҖӮ

еҜ№дёҠдёҖдёӘж—¶й—ҙзӘ—еҸЈеҶ…иө„жәҗдҪҝз”ЁзҺҮжҢҮж Ү пјҢ йҮҮз”Ёжң¬ж–ҮжҸҗеҮәзҡ„е®№еҷЁе®һдҫӢж•°йҮҸи®Ўз®—е…¬ејҸжҲ–з”ЁжҲ·е®ҡд№үиҮӘе®ҡд№үзҡ„е…¬ејҸиҝӣиЎҢи®Ўз®— пјҢ еҫ—еҲ°дёӢдёҖдёӘж—¶й—ҙзӘ—еҸЈеҶ…жңҹжңӣзҡ„е®№еҷЁе®һдҫӢж•°йҮҸ пјҢ 然еҗҺеҖҹеҠ©Kubernetesдёӯзҡ„жЁӘеҗ‘иҮӘеҠЁжү©зј©е®№зҡ„еҠҹиғҪпјҲHorizontalPod Autoscaling пјҢ з®Җз§° HPAпјү пјҢ иҮӘеҠЁеҢ–ең°и°ғж•ҙе®№еҷЁе®һдҫӢж•°йҮҸ пјҢ 然еҗҺпјҲJпјүзі»з»ҹ/жңҚеҠЎзҠ¶жҖҒзӣ‘жҺ§жЁЎеқ—继з»ӯе®һж—¶зӣ‘жҺ§жӣҙж–°еҗҺеҗ„е®№еҷЁе®һдҫӢзҡ„иө„жәҗдҪҝз”ЁзҺҮзӯүжҢҮж Ү пјҢ д»ҘжӯӨеҫӘзҺҜ пјҢ е®һзҺ°жЁЎеһӢеңЁзәҝжҺЁзҗҶжңҚеҠЎиө„жәҗзҡ„еҠЁжҖҒи°ғж•ҙ гҖӮ

жңҹжңӣзҡ„е®№еҷЁе®һдҫӢж•°йҮҸи®Ўз®—е…¬ејҸеҰӮдёӢжүҖзӨәпјҡ

жҺЁиҚҗйҳ…иҜ»

- дёҖзҜҮзҹӯж–Үд»Ӣз»Қ Defer жҳҜеҰӮдҪ•е·ҘдҪңзҡ„

- python еҰӮдҪ•дҪҝз”ЁHttpRunnerеҒҡжҺҘеҸЈиҮӘеҠЁеҢ–жөӢиҜ•

- ж— жңҚеҠЎеҷЁжҠҖжңҜеҰӮдҪ•е®һзҺ°жңҖдҪізҡ„DevOpsе®һи·ө

- еҰӮдҪ•з”ЁDL4Jжһ„е»әиө·дёҖдёӘдәәи„ёиҜҶеҲ«зі»з»ҹ

- еҰӮдҪ•зңӢе®ўеҺ…йЈҺж°ҙжҳҜи—ҸйЈҺзәіж°”иҝҳжҳҜдёҖжі»еҚғйҮҢпјҹ

- е®ўеҺ…йЈҺж°ҙпјҡе®ўеҺ…ең°жқҝеҰӮдҪ•иЈ…йҘ°пјҹ

- еҰӮдҪ•и®©е®ўеҺ…йЈҺж°ҙеёҰеҠЁе®¶еұ…иҝҗж°”

- е®ўеҺ…зҡ„жІҷеҸ‘еә”еҪ“еҰӮдҪ•ж‘Ҷж”ҫпјҹ

- е®ўеҺ…йЈҺж°ҙпјҡеҰӮдҪ•еёғзҪ®е®ўеҺ…зҡ„иҙўдҪҚпјҹ

- й»„еұұжҜӣеі°иҢ¶зҡ„еҶІжіЎж–№жі•,й»„еұұжҜӣеі°еҰӮдҪ•еҶІжіЎ