еҲӣе»әд»»еҠЎе·ҘеҺӮзҡ„еҸҰдёҖз§Қж–№ејҸ

д№ӢеүҚеңЁеҲӣе»әд»»еҠЎе·ҘеҺӮзҡ„ж—¶еҖҷ пјҢ жҳҜе°ҶеҮҪж•°еҜје…ҘеҲ° app.py дёӯ пјҢ 然еҗҺйҖҡиҝҮ add = app.task(add) зҡ„ж–№ејҸжүӢеҠЁиЈ…йҘ° пјҢ еӣ дёәжңүе“Әдәӣд»»еҠЎе·ҘеҺӮеҝ…йЎ»иҰҒи®© worker зҹҘйҒ“ пјҢ жүҖд»ҘдёҖе®ҡиҰҒеңЁ app.py йҮҢйқўеҮәзҺ° гҖӮдҪҶжҳҜиҝҷжҳҫ然дёҚеӨҹдјҳйӣ… пјҢ йӮЈд№ҲеҸҜдёҚеҸҜд»Ҙиҝҷд№ҲеҒҡе‘ўпјҹ

# celery_demo/tasks/task1.py

from app import app

# celery_demo жүҖеңЁи·Ҝеҫ„дҪҚдәҺ sys.path дёӯ

# еӣ жӯӨиҝҷйҮҢеҸҜд»ҘзӣҙжҺҘ from app import app

@app.task

def add(x, y):

return x + y

@app.task

def sub(x, y):

return x - y

# celery_demo/app.py

from tasks.task1 import add, sub

жҢүз…§дёҠйқўиҝҷз§ҚеҒҡжі• пјҢ зҗҶжғідёҠеҸҜд»Ҙ пјҢ дҪҶзҺ°е®һдёҚиЎҢ пјҢ еӣ дёәдјҡеҸ‘з”ҹеҫӘзҺҜеҜје…Ҙ гҖӮ

жүҖд»Ҙ celery жҸҗдҫӣдәҶдёҖдёӘеҠһжі• пјҢ жҲ‘们дҫқж—§еңЁ task1.py дёӯ import app пјҢ дҪҶеңЁ app.py дёӯдёҚеҶҚдҪҝз”Ё import пјҢ иҖҢжҳҜйҖҡиҝҮ include еҠ иҪҪзҡ„ж–№ејҸ пјҢ жҲ‘们зңӢдёҖдёӢпјҡ

# celery_demo/tasks/task1.py

from app import app

@app.task

def add(x, y):

return x + y

@app.task

def sub(x, y):

return x - y

# celery_demo/app.py

from celery import Celery

import config

# йҖҡиҝҮ include жҢҮе®ҡеӯҳж”ҫд»»еҠЎзҡ„ py ж–Ү件

# жіЁж„Ҹе®ғе’Ң worker еҗҜеҠЁи·Ҝеҫ„д№Ӣй—ҙзҡ„е…ізі»

# жҲ‘们жҳҜеңЁ celery_demo зӣ®еҪ•дёӢеҗҜеҠЁзҡ„ worker

# жүҖд»Ҙеә”иҜҘеҶҷжҲҗ "tasks.task1"

# еҰӮжһңжҳҜеңЁ celery_demo зҡ„дёҠдёҖзә§зӣ®еҪ•еҗҜеҠЁ worker

# йӮЈд№ҲиҝҷйҮҢе°ұиҰҒжҢҮе®ҡдёә "celery_demo.tasks.task1"

# еҪ“然еҗҜеҠЁж—¶зҡ„ -A app д№ҹиҰҒжҚўжҲҗ -A celery_demo.app

app = Celery(__name__, include=["tasks.task1"])

# еҰӮжһңиҝҳжңүе…¶е®ғж–Ү件 пјҢ жҜ”еҰӮ task2.py, task3.py

# йӮЈд№Ҳе°ұжҠҠ "tasks.task2", "tasks.task3" еҠ иҝӣеҺ»

app.config_from_object(config)

еңЁ celery_demo зӣ®еҪ•дёӢйҮҚж–°еҗҜеҠЁ worker гҖӮ

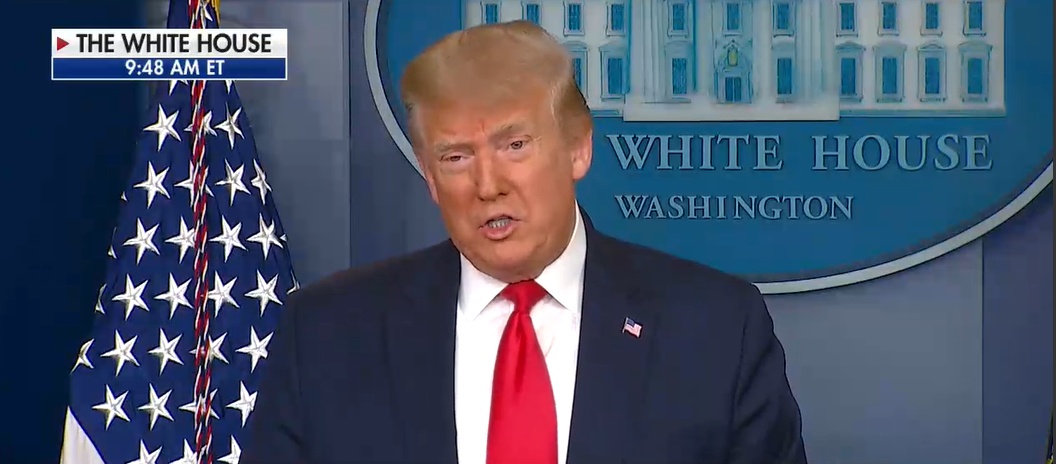

ж–Үз« жҸ’еӣҫ

дёәдәҶж–№дҫҝ пјҢ жҲ‘们еҸӘдҝқз•ҷдәҶдёӨдёӘд»»еҠЎе·ҘеҺӮ гҖӮеҸҜд»ҘзңӢеҲ°жӯӨж—¶е°ұжҲҗеҠҹеҗҜеҠЁдәҶ пјҢ 并且д№ҹжӣҙеҠ ж–№дҫҝе’Ңдјҳйӣ…дёҖдәӣ гҖӮд№ӢеүҚжҳҜеңЁ task1.py дёӯе®ҡд№үеҮҪж•° пјҢ 然еҗҺеҶҚжҠҠ task1.py дёӯзҡ„еҮҪж•°еҜје…ҘеҲ° app.py йҮҢйқў пјҢ 然еҗҺжүӢеҠЁиҝӣиЎҢиЈ…йҘ° гҖӮиҷҪ然иҝҷд№ҲеҒҡжҳҜжІЎй—®йўҳзҡ„ пјҢ дҪҶеҫҲжҳҺжҳҫиҝҷз§ҚеҒҡжі•дёҚйҖӮеҗҲз®ЎзҗҶ гҖӮ

жүҖд»ҘиҝҳжҳҜиҰҒе°Ҷ app.py дёӯзҡ„ app еҜје…ҘеҲ° task1.py дёӯзӣҙжҺҘеҲӣе»әд»»еҠЎе·ҘеҺӮ пјҢ дҪҶеҰӮжһңеҶҚе°Ҷ task1.py дёӯзҡ„д»»еҠЎе·ҘеҺӮеҜје…ҘеҲ° app.py дёӯе°ұдјҡеҸ‘з”ҹеҫӘзҺҜеҜје…Ҙ гҖӮдәҺжҳҜ celery жҸҗдҫӣдәҶдёҖдёӘ include еҸӮж•° пјҢ еҸҜд»ҘеңЁеҲӣе»ә app зҡ„ж—¶еҖҷиҮӘеҠЁе°ҶйҮҢйқўжүҖжңүзҡ„д»»еҠЎе·ҘеҺӮеҠ иҪҪиҝӣжқҘ пјҢ 然еҗҺеҗҜеҠЁе№¶е‘ҠиҜү worker гҖӮ

жҲ‘们жқҘжөӢиҜ•дёҖдёӢпјҡ

# йҖҡиҝҮ tasks.task1 еҜје…Ҙд»»еҠЎе·ҘеҺӮ

# 然еҗҺеҲӣе»әд»»еҠЎ пјҢ еҸ‘йҖҒиҮійҳҹеҲ—

>>> from tasks.task1 import add, sub

>>> add.delay(11, 22).get()

33

>>> sub.delay(11, 22).get()

-11жҹҘзңӢдёҖдёӢ worker зҡ„иҫ“еҮәпјҡ

ж–Үз« жҸ’еӣҫ

з»“жһңдёҖеҲҮжӯЈеёё гҖӮ

Task еҜ№иұЎ

жҲ‘们д№ӢеүҚйҖҡиҝҮеҜ№дёҖдёӘеҮҪж•°дҪҝз”Ё @app.task еҚіеҸҜе°Ҷе…¶еҸҳжҲҗдёҖдёӘд»»еҠЎе·ҘеҺӮ пјҢ иҖҢиҝҷдёӘд»»еҠЎе·ҘеҺӮе°ұжҳҜдёҖдёӘ Task е®һдҫӢеҜ№иұЎ гҖӮиҖҢжҲ‘们еңЁдҪҝз”Ё @app.task зҡ„ж—¶еҖҷ пјҢ е…¶е®һжҳҜеҸҜд»ҘеҠ дёҠеҫҲеӨҡзҡ„еҸӮж•°зҡ„ пјҢ еёёз”ЁеҸӮж•°еҰӮдёӢпјҡ

-

nameпјҡй»ҳи®Өзҡ„д»»еҠЎеҗҚжҳҜдёҖдёӘuuid пјҢ жҲ‘们еҸҜд»ҘйҖҡиҝҮ name еҸӮж•°жҢҮе®ҡд»»еҠЎеҗҚ пјҢ еҪ“然иҝҷдёӘ name е°ұжҳҜ apply_async зҡ„еҸӮж•° name гҖӮеҰӮжһңеңЁ apply_async дёӯжҢҮе®ҡдәҶ пјҢ йӮЈд№Ҳд»Ҙ apply_async жҢҮе®ҡзҡ„дёәеҮҶпјӣ

-

bindпјҡдёҖдёӘ bool еҖј пјҢ иЎЁзӨәжҳҜеҗҰе’Ңд»»еҠЎе·ҘеҺӮиҝӣиЎҢз»‘е®ҡ гҖӮеҰӮжһңз»‘е®ҡ пјҢ д»»еҠЎе·ҘеҺӮдјҡдҪңдёәеҸӮж•°дј йҖ’еҲ°ж–№жі•дёӯпјӣ

-

baseпјҡе®ҡд№үд»»еҠЎзҡ„еҹәзұ» пјҢ з”ЁдәҺе®ҡд№үеӣһи°ғеҮҪж•° пјҢ еҪ“д»»еҠЎеҲ°иҫҫжҹҗдёӘзҠ¶жҖҒж—¶и§ҰеҸ‘дёҚеҗҢзҡ„еӣһи°ғеҮҪж•° пјҢ й»ҳи®ӨжҳҜ Task пјҢ жүҖд»ҘжҲ‘们дёҖиҲ¬дјҡиҮӘе·ұеҶҷдёҖдёӘзұ»з„¶еҗҺ继жүҝ Taskпјӣ

-

default_retry_delayпјҡи®ҫзҪ®иҜҘд»»еҠЎйҮҚиҜ•зҡ„延иҝҹжңәеҲ¶ пјҢ еҪ“д»»еҠЎжү§иЎҢеӨұиҙҘеҗҺ пјҢ дјҡиҮӘеҠЁйҮҚиҜ• пјҢ еҚ•дҪҚжҳҜз§’ пјҢ й»ҳи®ӨжҳҜ3еҲҶй’ҹпјӣ

жҺЁиҚҗйҳ…иҜ»

- йҫҷд№Ӣ家ж—Ҹ|гҖҠйҫҷд№Ӣ家ж—ҸгҖӢиҝҷ1з»ҶиҠӮпјҢжҡ—зӨәдәҶдё№еҰ®иҺүдёқпјҢжүҚжҳҜжңҖдјҹеӨ§зҡ„еқҰж јеҲ©е®үпјҹ

- е°Ҹзұі|37еІҒиҙўеҜҢиҮӘз”ұпјҒйӣ·еҶӣжҺҘеҸ—еӨ®и§ҶйҮҮи®ҝпјҡжҲ‘иҰҒжҲҗдјҹеӨ§зҡ„дәә е°ҸзұіиҰҒеҪұе“Қдё–з•ҢгҖҒйҖ иҪҰжҳҜиў«йҖјзҡ„

- дёӯеӣҪжңҖеӨ§зҡ„еІӣеұҝжҳҜж—Ҙжң¬еІӣ дёӯеӣҪжңҖеӨ§зҡ„еІӣеұҝжҳҜд»Җд№ҲеІӣ-еј йӣӘеі°

- зӣӣжҳҺе…°|йҮҚжё©гҖҠзҹҘеҗҰгҖӢпјҢзҺӢиҖҒеӨӘеёҲдёҖз”ҹжңҖеӨ§зҡ„иҙҘ笔пјҢе°ұжҳҜеЁ¶дәҶеҒҸеҝғзҡ„зҺӢиҖҒеӨӘеӨӘ

- йҹ©еү§|гҖҠеҪ“дҪ жІүзқЎж—¶гҖӢпјҡеҪ“еҷ©жўҰз…§иҝӣзҺ°е®һпјҢж•‘иөҺе’ҢдҝЎд»»жүҚжҳҜжңҖејәзҡ„йҷӘдјҙ

- иөөй№Ҹзҝ”|вҖңжқҺжҳ“еі°вҖқдәӢ件жңҖеӨ§зҡ„еҸ—зӣҠиҖ…жҳҜи°Ғпјҹ

- зҪҡзҪӘ|гҖҠзҪҡзҪӘгҖӢпјҡеӨ§зҺӢзҺ°иә«пјҢжҳҜе…Ёеү§жңҖеӨ§зҡ„еҸҚиҪ¬еҗ—пјҢзҪ‘еҸӢпјҡдёҚжҳҜзҡ„

- |иғҪеҠӣпјҢи®©дёҖдёӘдәәиҝ…йҖҹи„ұйў–иҖҢеҮәпјҢеҰӮдҪ•еҸ‘жҢҘеҮәдҪ зҡ„жңҖејәжҠҖиғҪпјҹ

- еҚҺдёә|е–·й—®з•ҢM7дёҚеҘҪзңӢзҡ„дәәе“ҒдҪҚжҜ”иҫғLowпјҒдҪҷжүҝдёңпјҡеҚҺдёәеҒҡдјҹеӨ§зҡ„и®ҫи®Ў

- жңҖеӨ§зҡ„жҒҗйҫҷжңүеӨҡеӨ§ жңҖеӨ§зҡ„жҒҗйҫҷжҺ’иЎҢжҰңеүҚеҚҒеҗҚ